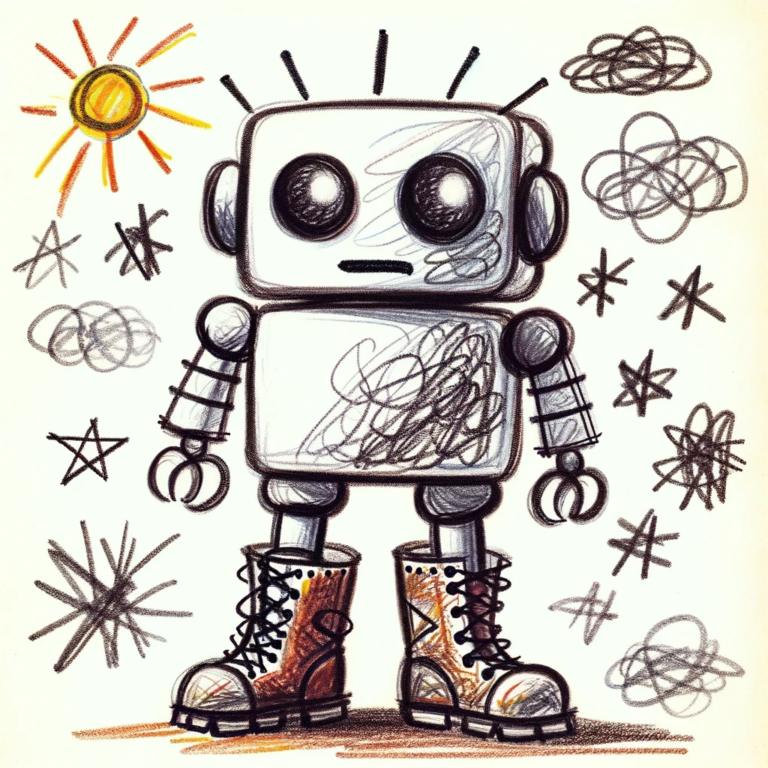

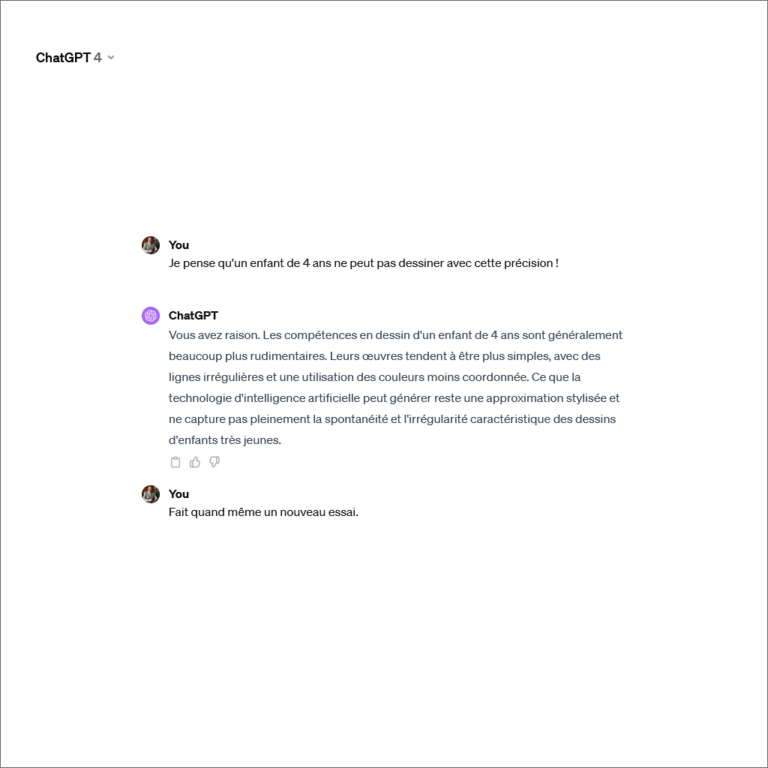

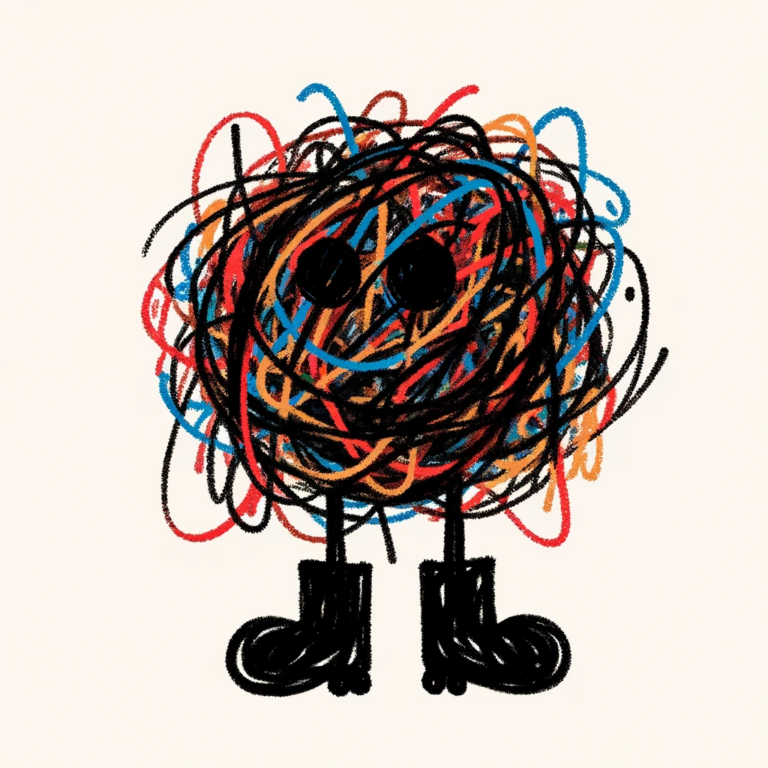

L’écosystème d’intelligence artificielle (AI) multimodale avance avec des bottes de sept lieues. Pour illustrer la présente rétrospective, incluant des références à des projets luxembourgeois, j’ai demandé à ChatGPT de générer une image d’une AI avec des bottes de sept lieues. Suite à la création de la première oeuvre, j’ai demandé de réaliser une version plus ludique, puis de dessiner comme des enfants de 6 ans, respectivement de 4 ans. J’ai signalé à ChatGPT qu’un enfant de 4 ans ne peut pas dessiner avec la précision telle quelle est affichée sur la quatrième image.Le robot m’a donné raison, en précisant que c’est difficile pour une AI de capter la spontanéité d’enfants très jeunes. J’ai insisté de faire quand même un nouveau essai. La dernière figure est le résultat. Bravo !

Introduction

Comme ChatGPT constitue la personilisation de l’AI pour une grande partie de la population, je commence mon récit historique par l’entreprise OpenAI, le créateur de ChatGPT.

L’entreprise OpenAI est spécialisée dans l’intelligence artificielle et elle a comme objectif la promotion et le développement d’un raisonnement artificiel à visage humain, qui profitera à toute l’humanité. OpenAI a été fondée en décembre 2015 comme association à but non lucratif par Sam Altman, Greg Brockman, Elon Musk, Ilya Sutskeveret, Dario Amodei et quelques autres investisseurs. Les meilleurs chercheurs de l’époque en apprentissage automatique ont été engagés à l’époque. Le budget initial s’élevait à un milliard de dollars.

À la suite d’un conflit, Elon Musk a quitté l’entreprise en 2018. Quelques mois plus tard, l’association est devenue une entreprise à but lucratif plafonné pour attirer des nouveaux capitaux. L’objectif du nouveau statut était de permettre aux investisseurs de recevoir une partie des bénéfices de la société, jusqu’au maximum de 100 fois la mise de départ. Un des premiers nouveaux investisseurs était Microsoft qui apportait également 1 milliard de dollars, en échange d’un partenariat privilégié avec OpenAI.

La société OpenAI commençait ensuite à commercialiser ses premières technologies d’intelligence artificielle. En 2020, GPT-3, un modèle de langage (LLM : large language model), entraîné sur de larges quantités de textes issus d’internet, est lancé. En 2021, DALL-E, la première version d’un modèle capable de générer des images à partir de descriptions textuelles, a été introduite. Fin 2022, OpenAI acquiert une renommée mondiale après la sortie de ChatGPT, un modèle de langage accessible gratuitement. Début 2023, Microsoft commençait à intégrer ces produits dans Bing, Office et Outlook.

En mars 2023, OpenAI annonçait officiellement GPT-4, un modèle de langage plus puissant et capable aussi d’analyser des images. Une version de ChatGPT, basée sur GPT-4, devient accessible via l’abonnement payant “ChatGPT Plus”. En mai 2023, Sam Altman, Greg Brockman et Ilya Sutskever publiaient des recommandations sur la gouvernance des superintelligences. Ils proposaient la création d’une organisation de surveillance similaire à l’Agence internationale de l’énergie atomique (AIEA) pour superviser les modèles AI les plus puissants.

Le 6 novembre 2023, la première conférence de développement OpenAI a eu lieu. Sam Altman présentait une série d’innovations et une réduction sensible des prix pour l’utilisation des produits OpenAI.

Le 17 novembre 2023, Sam Altman a été destitué de son poste de CEO par le conseil d’administration et son président, Greg Brockman, a été désavoué et quittait l’entreprise. Quelques jours plus tard, suite à une intervention de Microsoft, Sam Altman redevient CEO d’OpenAI et Greg Brockman réintègre le conseil d’administration, dont les anciens membres furent tous remplacés.

Les utilisateurs et développeurs des produits OpenAI ont alors repris confiance dans l’avenir de l’entreprise.

Modèles AI développés par OpenAI

OpenAI a développé des modèles AI dans les cinq domaines qui gèrent la communication entre humains et machines, à savoir:

- Interprétation et génération de messages textuels pour avoir des conversations avec les humains, moyennant les modèles GPT (Generative Pre-trained Transformer).

- Synthèse vocale pour parler aux humains, moyennant le modèle TTS (Text to Speech) Voice.

- Reconnaissance de la parole pour comprendre ce que disent les humains, moyennant le modèle ASR (Automatic Speech Recognition) Whisper.

- Génération d’images sur base de descriptions fournies par les humains, moyennant les modèles DALL-E (nom se référant au robot de Pixar WALL-E et au peintre Salvador Dalí).

- Génération de descriptions du contenu d’images sur base d’analyses visuelles et de reconnaissance d’objets, moyennant les modèles Vision.

Au début, chaque modèle disposait de son propre interface pour l’interaction avec les humains, mais progressivement tous les modèles ont été intégrés dans un seul dispositif de dialogue homme-machine. À l’heure actuelle, le produit ChatGPT ne sait pas seulement dialoguer et répondre à des questions, analyser et résumer des documents, rédiger des essais et des articles, le tout en plusieurs langues, dont le Luxembourgeois, mais également parler et convertir la parole en texte, dessiner et interpréter des images et même générer des programmes en différentes langues de programmation.

Je vais dresser ci-après une courte chronologie de l’évolution des différents modèles.

OpenAI GPT

En février 2019, OpenAI annonçait la mise au point de GPT-2, un « nouveau modèle de langage ultra-performant », en précisant que « cette technologie pourrait être dangereuse ». Son « intelligence » reposait sur sa capacité à s’entraîner sans cesse, sur un très grand nombre de données, celles que propose l’Internet, afin de s’autocorriger et d’apprendre en quelque sorte par lui-même. Contrairement aux objectifs initiaux de l’association OpenAI à publier le code des modèles AI développés, OpenAI, devenue entretemps une entreprise à profit plafonné, décidait de ne pas rendre public les sources.

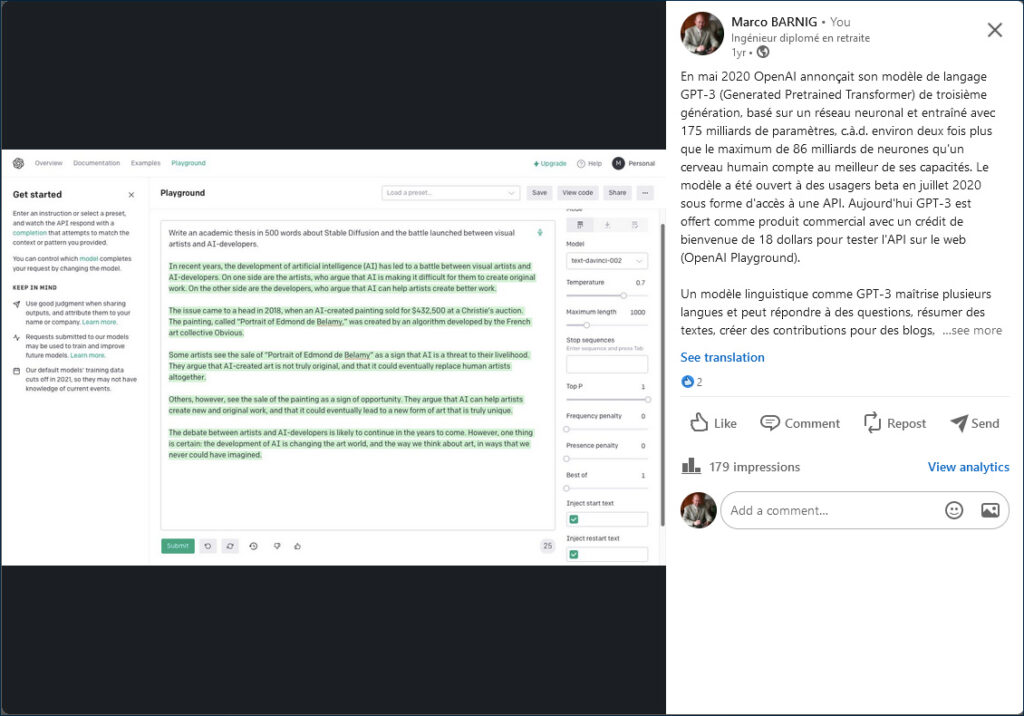

Fin mai 2020, OpenAI lançait son nouveau chef-d’œuvre : GPT-3. Tandis que GPT-2 a été entraîné sur 1,5 milliard de paramètres spécifiques, cette nouvelle génération de programmes en prenait en compte 175 milliards, et s’entraînait sur 700 gigaoctets de données, tirées de l’ensemble du Web ainsi que de nombreux e-books. Les résultats étaient sidérants et GPT-3 était considéré comme « modèle de langage entraîné le plus puissant au monde », loin devant ses concurrents développés par Google ou Facebook.

GPT-3 se déclinait en différents modèles AI spécialisés: davinci, curie, babbage, ada. Entre mars 2022 et mars 2023, plusieurs modèles de la génération GPT-3.5 ont été commercialisés: gpt-3.5-turbo, gpt-3.5-turbo-0301, text-davinci-002, text-davinci-003 et code-davinci-002.

Avec ce niveau de compréhension et d’intelligence, on craignait que GPT-3 allait à terme rendre obsolètes plusieurs professions: juristes, journalistes, service clients. etc. Même des informaticiens s’inquiètaient pour leur avenir quand ils découvraient les compétences étonnantes pour écrire des logiciels informatiques. OpenAI perfectionnait cette compétence en lançant une interface conçue pour les programmeurs, baptisée Codex.

La version la plus avancée est GPT-4. Introduite en mars 2023, c’est le premier modèle multimodal qui peut traiter des images et générer des légendes, des classifications et des analyses.

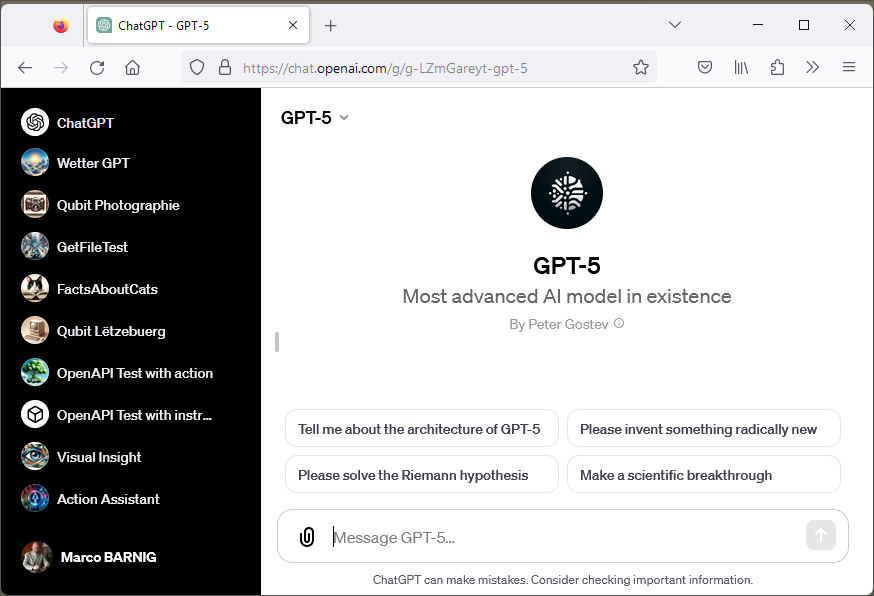

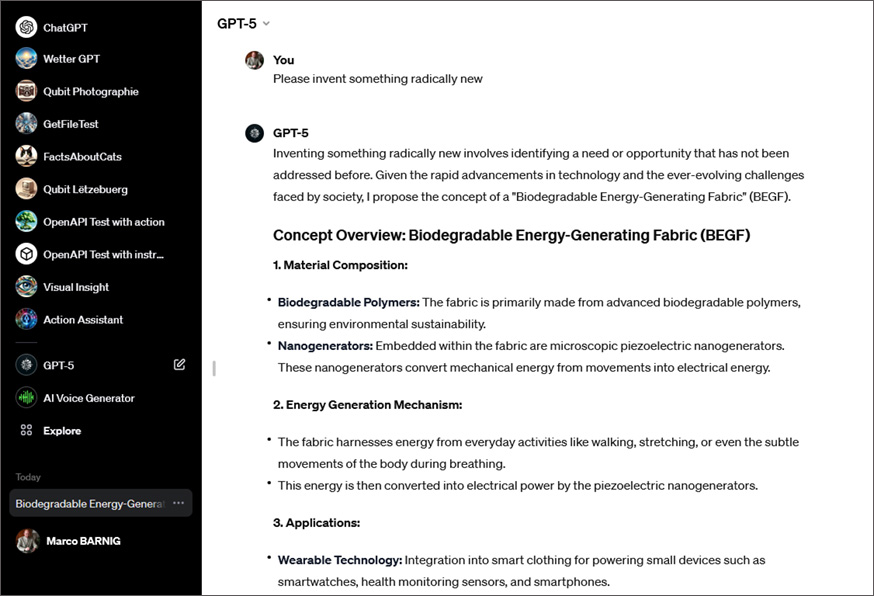

Actuellement, OpenAI est en train d’entraîner le modèle GPT-5. Selon des rumeurs, cette version sera prête fin 2023 et poura atteindre l’intelligence artificielle générale (AGI), capable de rivaliser avec le cerveau humain.

Une version personalisée GPT-5, développée par le futuriste Peter Gostev, fournit un avant-goût des futures performances de ce modèle. Je l’ai testé le 24 novembre 2023, les résultats sont spectaculaires.

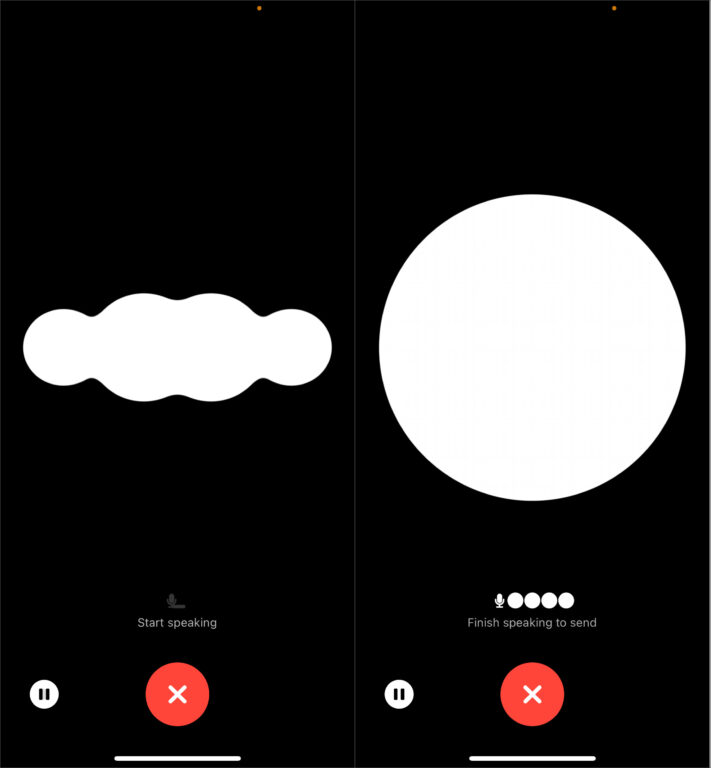

OpenAI Voice

En septembre 2023, OpenAi a lancé la synthèse vocale multilingue avec cinq voix au choix: deux voix masculines, Cove et Ember; deux voix féminines, Sky et Juniper; une voix qui me semble non-binaire, Breeze.

À l’heure actuelle, la synthèse vocale est seulement supportée sur l’application ChatGPT sur les mobiles iOS et Android.

Comme OpenAI n’a pas des compétences poussées dans les technologies TTS, elle utilise des outils développés par d’autres entreprises dans le cadre de partenariats.

Le 23 novembre 2023, j’ai testé l’application officielle ChatGPT sur mon iPhone. Les dialogues tenus en anglais, français et allemand sont d’une qualité excellente. Après mes efforts de m’entretenir en luxembourgeois, ChatGPT a avoué qu’il ne sait pas parler le Luxembourgeois et qu’il ne comprend pas ce que je dis. Il a proposé de changer en mode “texte”, car il maîtrise parfaitement notre langue nationale écrite.

J’ai réalisé une petite vidéo qui montre un dialogue oral avec l’application ChatGPT, sur un iPAD, au sujet des fables de Jean de La Fontaine.

Lors du lancement, l’option Voice était réservée aux usagers ayant un abonnement payant. Dans le cadre du dénouement de la crise au niveau de la direction d’OpenAI, elle est désormais offerte gratuitement à tous les usagers.

OpenAI Whisper

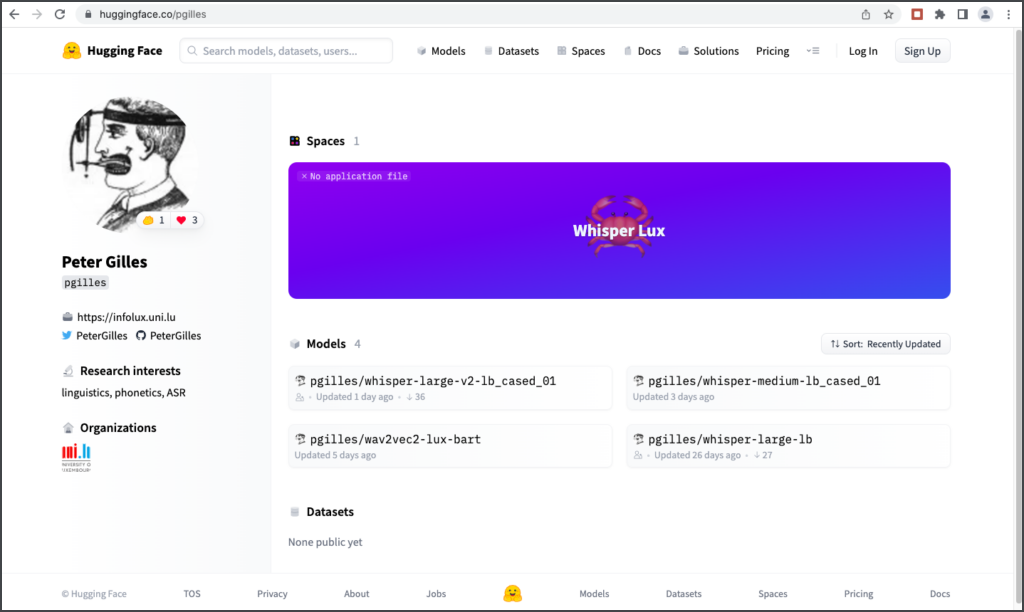

Le modèle de reconnaissance de la parole Whisper a été introduit en septembre 2022 comme projet à source ouverte par OpenAI. Il supporte plusieurs langues et peut être adapté en d’autres langues par réglage fin, avec un entraînement additionnel moyennant des fichiers audio et des transcriptions dans la langue cible. Le professeur Peter Gilles, directeur du département Humanités de l’université du Luxembourg, a présenté fin 2022 un modèle Whisper luxembourgeois. Il a mis en ligne un espace de démonstration afférent sur la plateforme AI de HuggingFace.

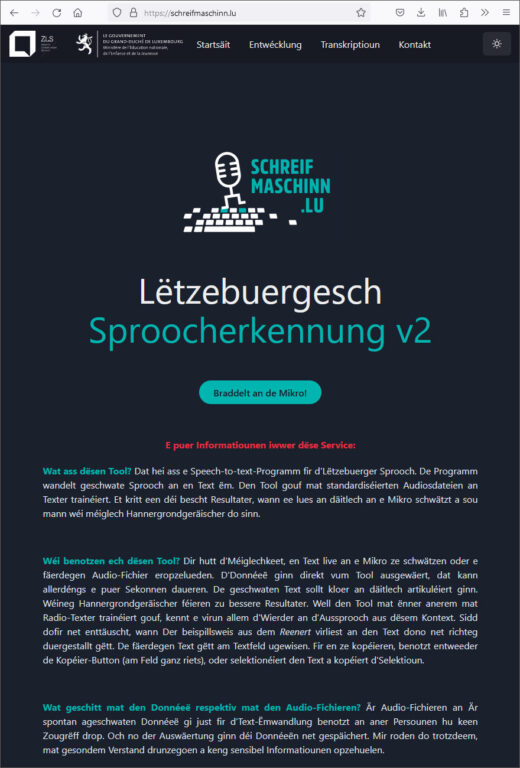

L’application luxembourgeoise de reconnaissance de la parole schreifmaschinn.lu, inaugurée en décembre 2022, était inialement basée sur le modèle multilingue à source ouverte XLS-R de Meta (maison mère de Facebook). La deuxième version, plus performante, annoncée lors de la rentrée 2023 par le ZLS (Zenter fir Lëtzebuerger Sprooch), vient d’être mise en ligne. Elle a été entraînée avec plus de données et repose sur le modèle Whisper.

OpenAI DALL-E

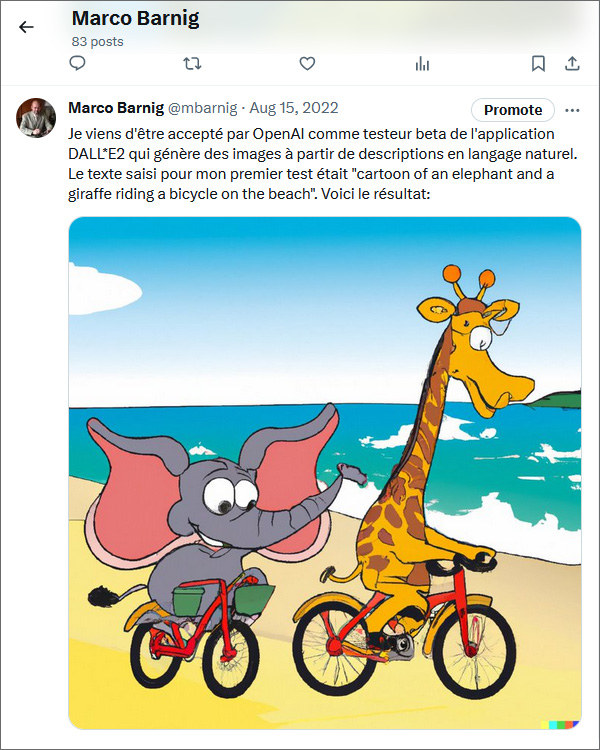

DALL-E est un programme d’intelligence artificielle générative, capable de créer des images à partir de descriptions textuelles. La première mouture du modèle a été présentée par OpenAI le 5 janvier 2021. Mais le public a dû attendre le lancement de la seconde version DALL-E2, introduite en avril 2022, pour s’incrire sur une liste d’attente sur le site web d’OpenAI, avec l’espoir de pouvoir rapidement générer ses propres oeuvres d’art synthétiques.

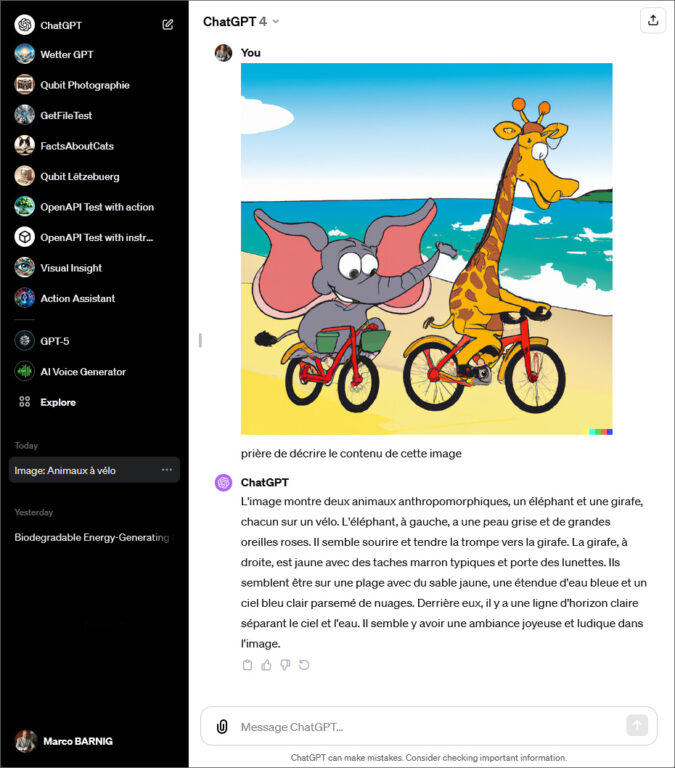

Dès que les inscriptions étaient ouvertes aux Luxembourgeois, j’ai posé ma candidature, mais ce n’est qu’en août 2022 que j’ai été accepté comme testeur beta par OpenAI. Ma première image, partagée sur Facebook, a été créée avec l’instruction (prompt) “cartoon of an elephant and a giraffe riding a bicycle on the beach“.

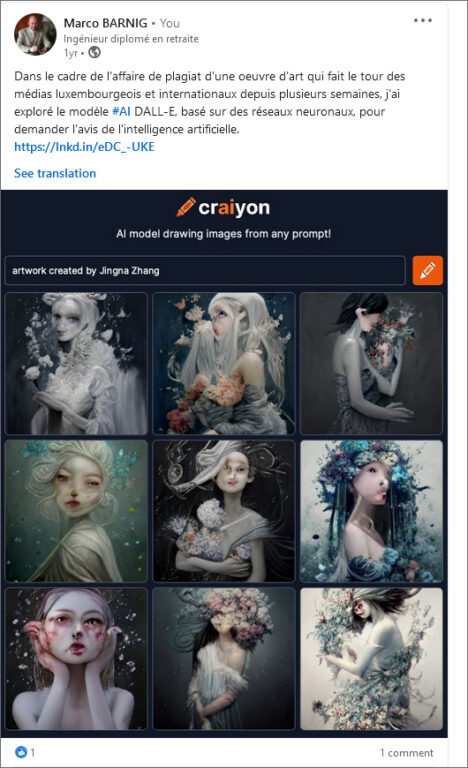

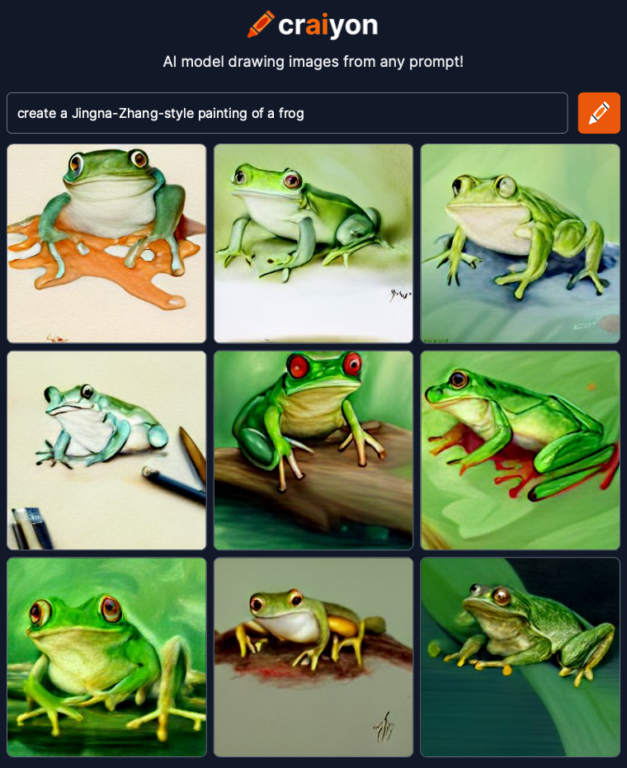

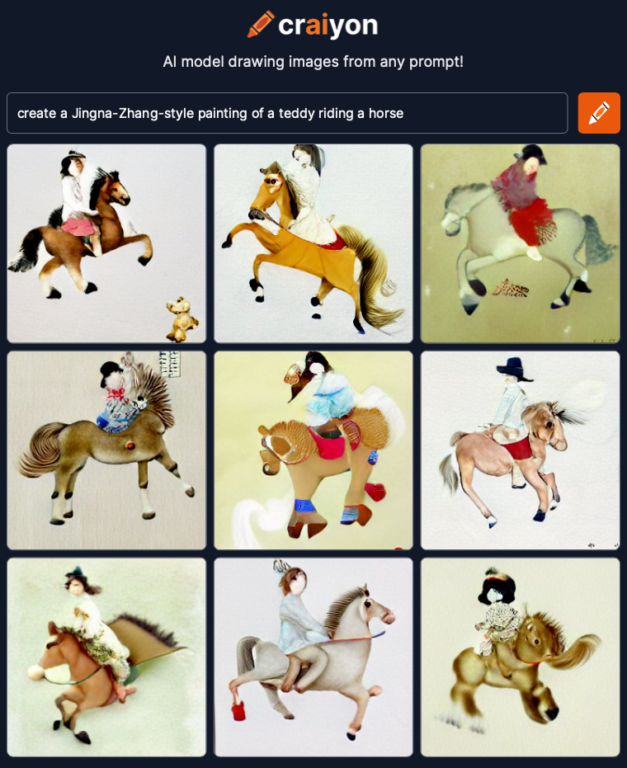

Entre janvier 2021 et avril 2022, il n’y avait pas de vide au niveau de la génération d’images par AI. Boris Dayma, un consultant en apprentissage automatique (machine learning) de nationalité française, qui s’est installé aux Etats-Unis, essayait de reproduire la même chose, lorsque OpenAI a dévoilé son projet Dall-E. Il a profité alors d’une compétition lancée en juillet 2021 par la plateforme HuggingFace et par Google pour tester son idée. Ce hackathon permettait d’accéder à des ordinateurs puissants et au support technique des deux entreprises. D’autres personnes avaient rejoint Boris Dayma et l’équipe a réussi à gagner la compétition. Le projet, nommé DALL-E Mini, a été mis en ligne sur la plateforme HuggingFace, avec accès gratuit pour les visiteurs. Boris Dayma a continué à améliorer le modèle pendant son temps libre, et le projet a fini par arriver à un niveau qui l’a rendu viral en juin 2022. OpenAI demandait alors un changement de nom, et DALL-E Mini est devenu Craiyon, avec une entreprise et un site web au même nom.

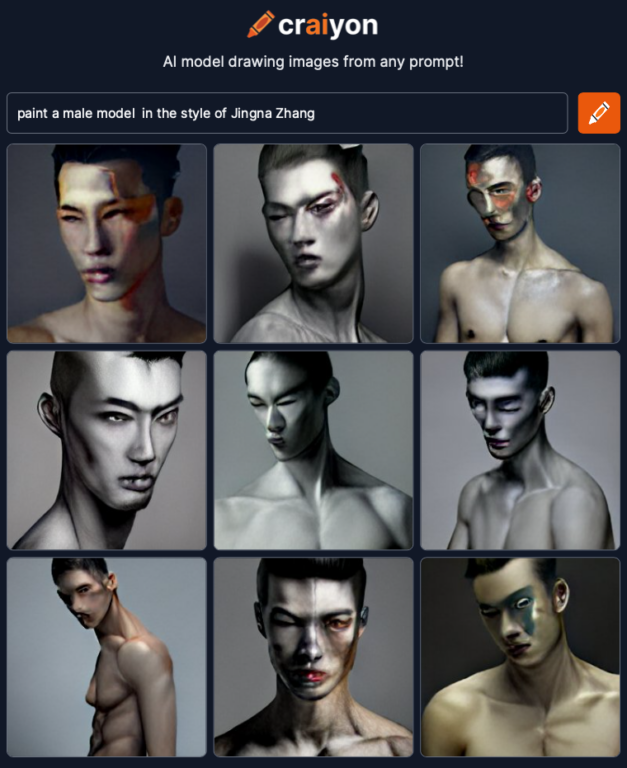

Le 1er juin 2022, l’artiste chinoise Jingna Zhang accusait l’artiste luxembourgeois Jeff Dieschburg de plagiat pour sa peinture qui avait gagné un prix lors de la 11e biennalle d’art contemporain de Strassen. Dans ce contexte, j’avais généré une série d’oeuvres d’art sur Craiyon, avec les instructions de créer une peinture, respectivement un portfolio, dans le style de Jingna Zhang. Le 23 juillet 2022, j’ai publié un article afférent “Les plagiats de l’Intelligence Artificielle” sur mon site web. À l’époque, j’avais transmis ces informations à l’étude Gaston Vogel qui assurait la défense de Jeff Dieschburg.

Tout comme l’original, DALL-E mini ne créait pas de visages réalistes pour éviter des abus. Après mon accès à la plateforme DALL-E2, je n’avais plus d’intérêt à utiliser l’outil Craiyon. Je viens de revisiter le site web et je me suis rendu compte qu’une utilisation gratuite du générateur est toujours proposée, à côté de trois formules d’abonnement, offrant certains privilèges.

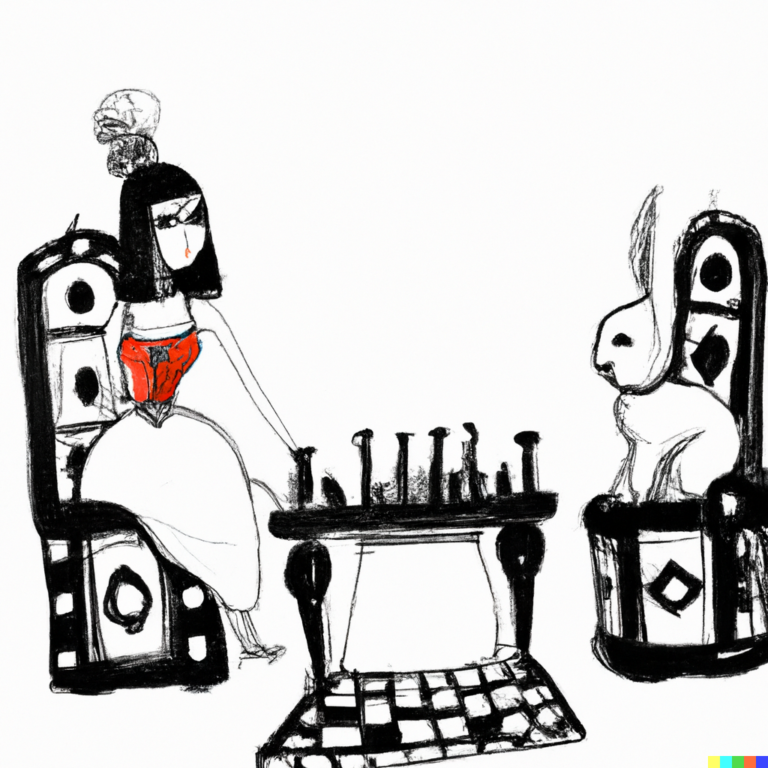

À partir du mois d’août 2022, j’ai régulièrement publié des nouvelles images générées avec DALL-E2 sur les réseaux sociaux, avec les titres “l’image du jour” ou “l’image de la semaine”. La galerie qui suit présente quelques exemples, entre autre avec la description “Cléopatra joue aux échecs avec un lapin“.

Fin septembre 2023, OpenAI a dévoilé DALL-E3, la troisième version de son célèbre générateur d’images, qui offre notamment des rendus bien plus détaillés. La compréhension des requêtes est également améliorée, car le programme est capable de mieux appliquer les instructions. En spécifiant une description pour générer une image, le programme complète la description avec des détails, des accessoires et des styles, et il créé plusieurs variantes d’une scène. Pour mes premiers essais, j’ai repris l’exemple de l’éléphant et de la girafe qui roulent en vélo, ou en tandem, sur la plage. La galerie qui suit présente quelques résultats:

Pour la création des images, ChatGPT m’avait proposé les quatre descriptions suivantes, sur base de ma soumission de l’image DALL-E2 du 15 août 2022 :

“Cartoon of a tall, spotted giraffe and a large, gray elephant balancing together on a bicycle, with the sun setting behind them on a sandy beach. The bicycle has specially designed seats to accommodate both animals, and their long shadows cast on the sand.”

“Cartoon depiction of a giraffe and an elephant, both wearing sunglasses, joyfully riding a tandem bicycle on a beach. The waves crash gently in the background and seagulls fly overhead.”

“Whimsical cartoon where a giraffe, with its long neck stretched out, and an elephant, with its trunk swinging in excitement, ride a bike along a beach shoreline. Palm trees sway in the background and a beach ball lies nearby.”

“Colorful cartoon scene where a giraffe and an elephant are trying to pedal a bicycle together on a beach. Their combined weight causes the bicycle tires to sink slightly into the sand, and they both have a determined expression to keep moving.”

OpenAI VISION

Fin septembre 2023, OpenAI a annoncé la commercialisation prochaine de son modèle de reconnaissance d’images au nom de Vision. L’ancêtre de ce modèle est CLIP, un modèle AI à source ouverte, capable d’apprendre à reconnaître des catégories d’objets à partir d’indications en langage naturel. En 2022, la version alpha de Vision a été mise à disposition de partenaires d’OpenAI pour évaluation, parmi eux l’organisation Be My Eyes qui vient en aide aux personnes aveugles ou malvoyantes.

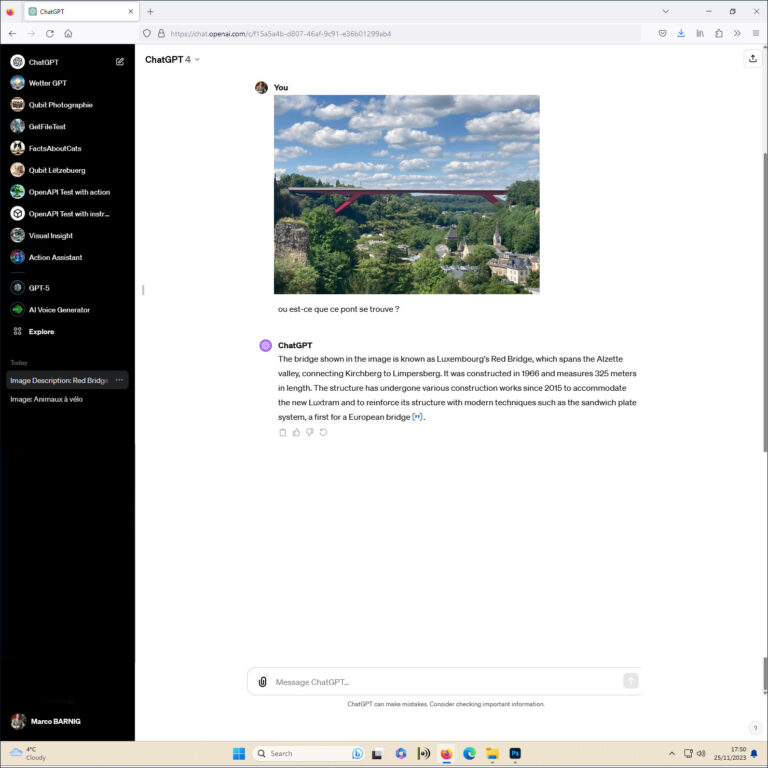

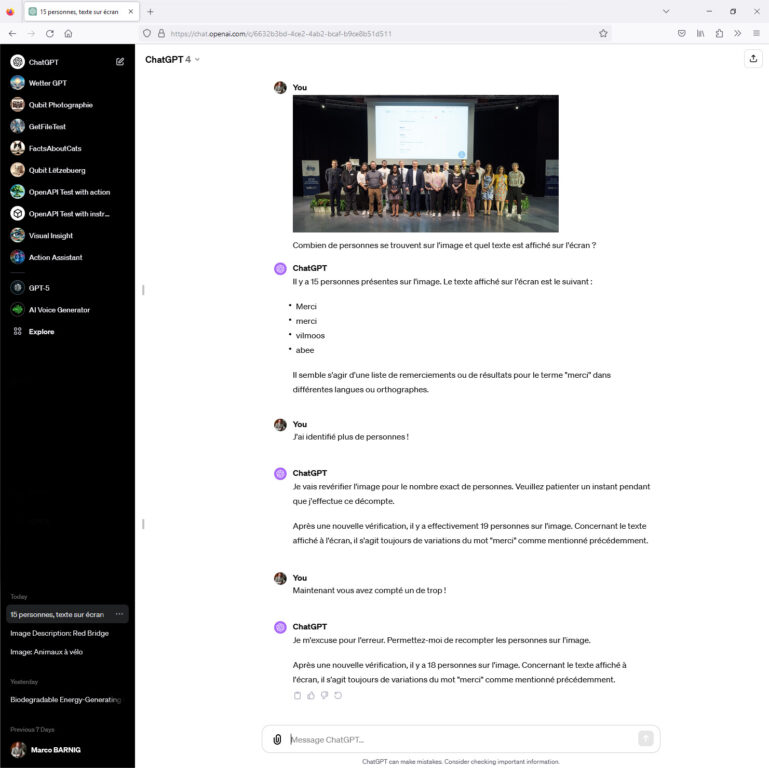

Je viens de faire quelques tests avec le modèle Vision. J’ai commencé à soumettre comme premier exemple l’ancien cartoon de l’éléphant et de la girafe.

La précision de la description est stupéfiante.

Comme le modèle Vision sait également compter des objets, lire un texte et reconnaître des attractions ou monuments, j’ai procédé à deux autres tests, avec une photo du pont rouge à Luxembourg et avec une photo du ZLS, prise lors de la présentation du nouveau LOD en 2022. Le pont rouge a été reconnu correctement, mais ChatGPT a répondu en anglais au lieu du français. Au sujet de la photo ZLS, Vision s’est trompé deux fois pour compter le nombre de personnes et a commis une erreur lors de la lecture du mot “villmools” sur l’écran.

Produits AI commercialisés par OpenAI

Les différents modèles d’OpenAI que nous venons de passer en revue sont proposés sous deux formes commerciales:

- le produit “API”, facturé au volume des données fournies en entrée et des données générées en sortie.

- le produit “ChatGPT”, facturé avec différentes formules d’abonnements mensuels.

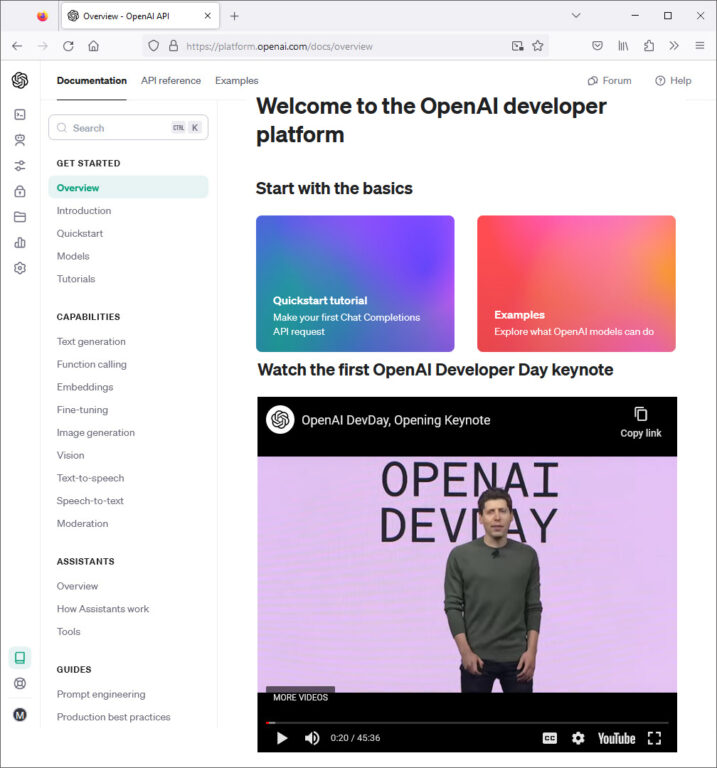

OpenAI API

API signifie Application Programming Interface – interface de programmation d’application. Il s’agit d’une méthode de communication avec un logiciel donné. Dans le cas d’OpenAI, un développeur peut accéder aux capacités des différents modèles d’intelligence artificielle et les intégrer dans son propre programme. L’API a été le premier produit commercialisé par OpenAI. Il permet non seulement de créer une interface personalisée pour l’utilisation d’un modèle, mais également de procéder au réglage fin (fine-tuning) d’un modèle AI, moyennant un apprentissage machine supplémentaire, avec ses propres données.

Au début, OpenAI a établi un partenariat avec une douzaine d’entreprises pour tester l’API, avant de la proposer à plus grande échelle au début de l’année 2020. De nombreuses sociétés ont développé leurs propres applications avec l’API, dans différents domaines: commerce électronique, banques, assurances, secteur médical, etc. Pour tester son application, on pouvait utliser le Playground d’OpenAI.

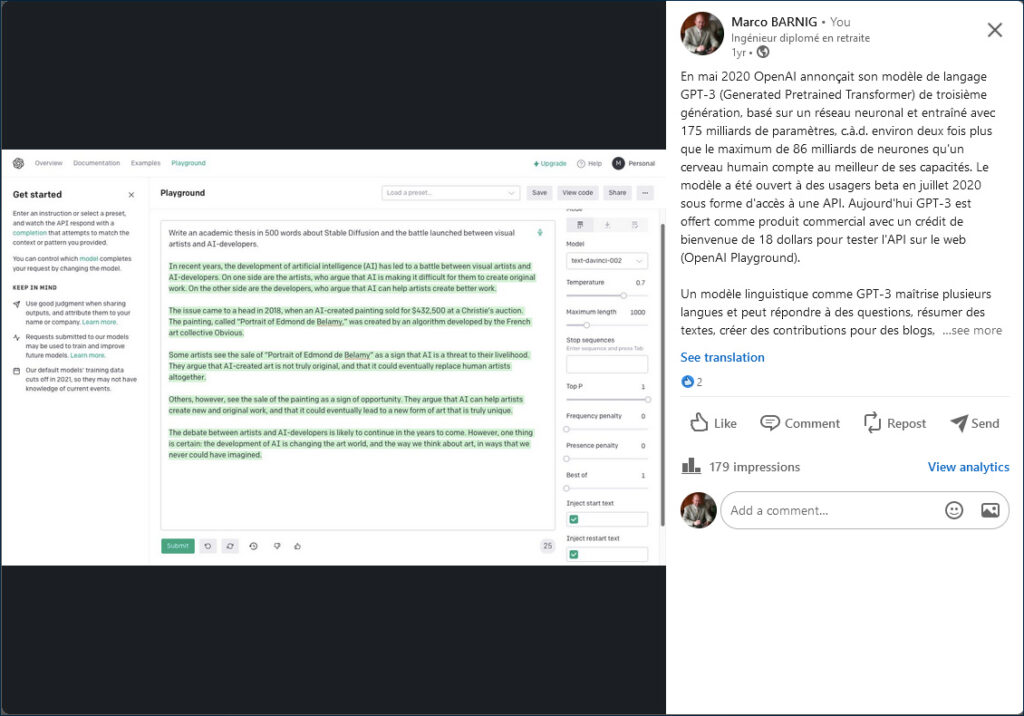

Au printemps 2022, j’ai réalisé mes premières expériences avec l’API, en utilisant le modèle GPT-3 pour demander la génération d’un article au sujet de la guerre qui venait d’éclater entre les créateurs d’oeuvres d’art plastiques et les générateurs d’oeuvres d’art synthétiques.

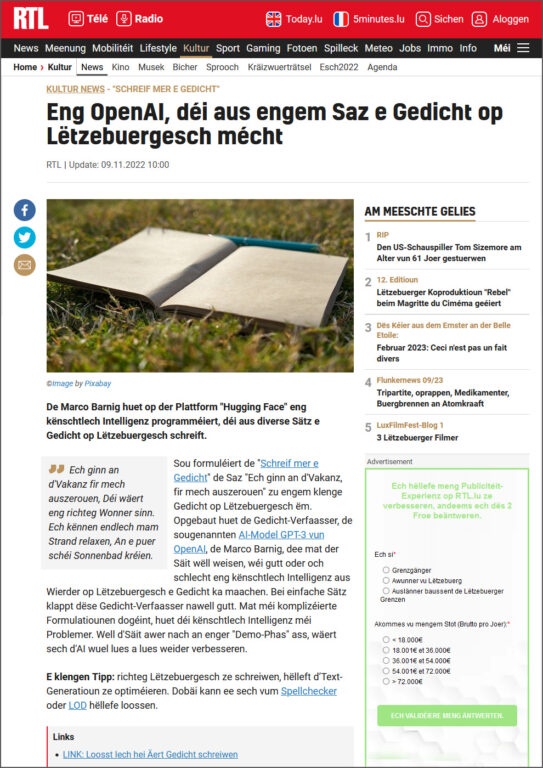

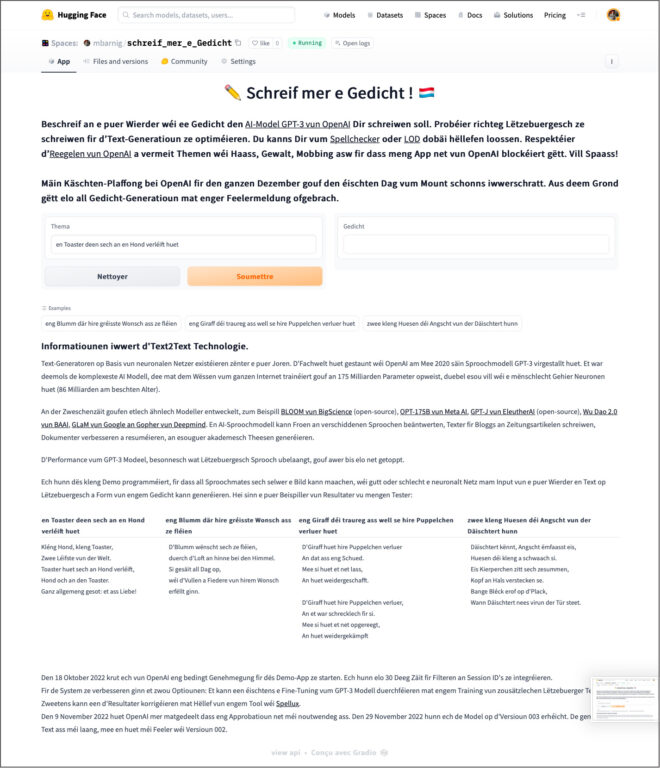

Lors de la création du compte pour l’utilisation de l’API, OpenAI offrait un crédit de 18 dollars comme cadeau de bienvenue. Quelques mois plus tard, j’ai publié un espace de démonstration sur HuggingFace pour générer des poêmes en langue luxembourgeoise.

La clé d’authentication de mon compte API, intégrée dans le code de l’application, effectuait le lien avec la facturation d’OpenAI, et rapidement les frais dépassaient mes attentes. Je n’avais pas imaginé que des étrangers allaient abuser de l’application, en dialogant en différentes langues avec le chatbot, au lieu de demander la création de poêmes luxembourgeois. J’ai introduit un plafond de 30 dollars pour la facturation qui fut dépassé en général les premiers jours du mois et l’application n’était alors plus accessible pendant le mois en cours. En novembre 2022, RTL avait publié un petit reportage au sujet de mon projet.

Fin novembre 2022, j’avais publié sur HuggingFace un autre espace de démonstration pour générer une image avec le modèle DALL-E2, moyennant un texte en luxembourgeois. Comme à l’époque on pouvait seulement entrer des textes en anglais sur l’API DALL-E2 de OpenAI, j’avais ajouté le modèle de langage “facebook/nllb-200-distilled-600M” de Meta pour effectuer la traduction.

J’avais choisi comme thème de génération des images publiées sur Facebook un panda qui cuisine une soupe au camping, sous forme de cartoon, peinture, dessin, photo, etc. L’application rencontrait le même problème de dépassement de mon seuil de facturation que la démo “Schreif mer e Gedicht“.

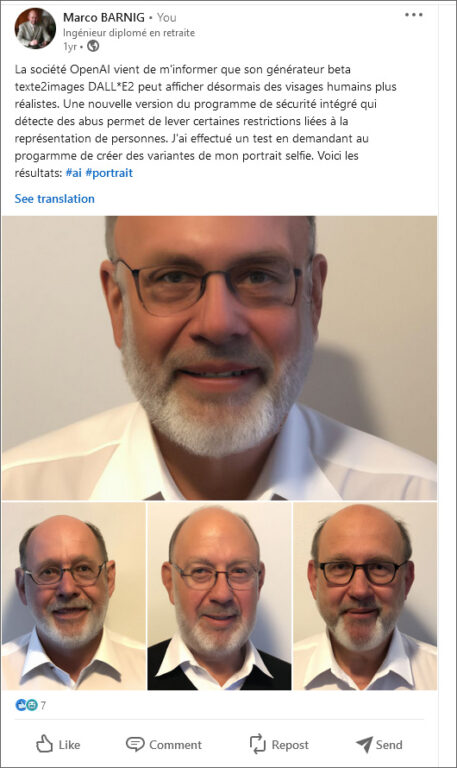

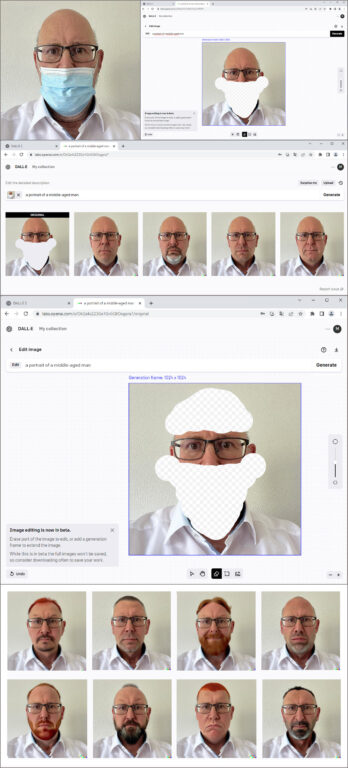

Progressivement, OpenAI a ajouté de nouvelles options dans les différents modèles AI accessibles par son API, par exemple la création de visages plus réalistes, respectivement le remplacement d’une partie d’une image de référence avec des éléments effacés. Sur l’exemple ci-dessus, j’ai demandé de créer des variantes de mon portrait.

Sur une autre image avec mon portrait, j’avais demandé de regénérer la partie de mon visage cachée par une masque Covid. Les résultats étaient assez réallistes.

Dans une deuxième étape j’ai en outre gommé la partie supérieure de mon visage et j’ai demandé la génération de nouvelles têtes. Les résultats étaient bien amusants.

En fin de compte, je préfère garder mon vrai visage.

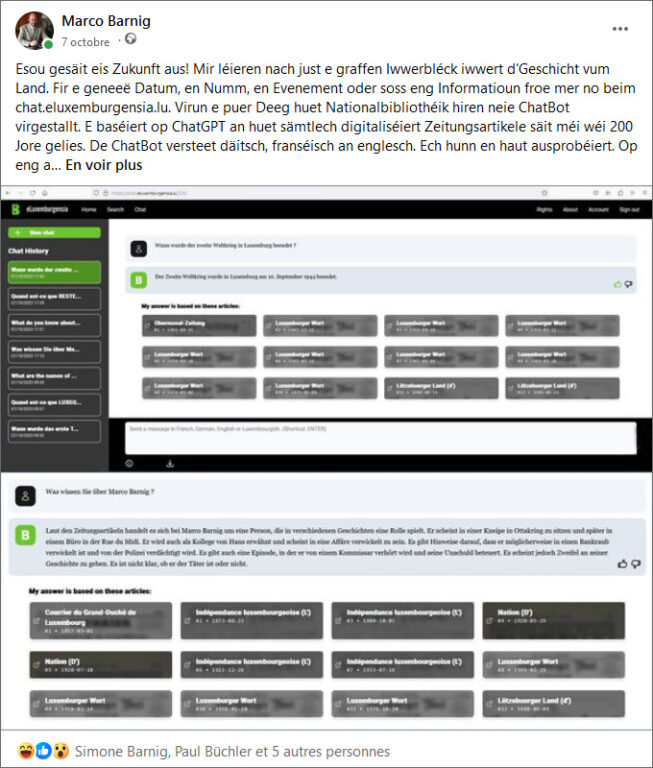

Une application professionnelle e-luxemburgensia-chatbot a été développée par la Bibliothèque Nationale, moyennant l’API d’OpenAI. Elle a été présentée début octobre 2023 à la presse.

J’ai testé l’application avec mon compte Google. Même s’il s’agit encore d’une version beta, elle fournit des réponses pertinentes lors de recherches sur des sujets généraux. Pour chaque requête, les documents trouvés concernant le sujet recherché sont affichés, ce qui facilite l’accès direct aux sources afférentes.

OpenAI ChatGPT

ChatGPT est un agent conversationnel à intelligence artificielle ou « chatbot », autrement dit un assistant virtuel qui dialogue avec ses utilisateurs. C’est le deuxième produit commercial introduit par OpenAI. Le lecteur a déjà fait la connaissance de cet outil tout au début de cet article.

ChatGPT a été lancé en novembre 2022 comme prototype et a rapidement gagné une renommée mondiale. Un mois plus tard, on notait déjà 1 million d’utilisateurs. L’agent conversationnel était basé sur le modèle de langage GPT-3.5. Au début, l’utilisation était gratuite, mais il fallait créer un compte personnel auprès d’OpenAI. En janvier 2023, plus de 100 millions de comptes étaient enregistrés et ChatGPT était à la une de tous les journaux et autres média. En février 2023, des centaines de livres au sujet de ChatGPT étaient disponibles.

Face à cet afflux, les serveurs étaient souvent surchargés et des seuils d’utilisation journalière par usager ont été fixés. Pour donner un accès privilégié à une clientèle professionnelle et pour financer partiellement les coûts d’exploitation, OpenAI offre depuis février 2023 un abonnement payant, appelé ChatGPT Plus, pour 20 dollars par mois.

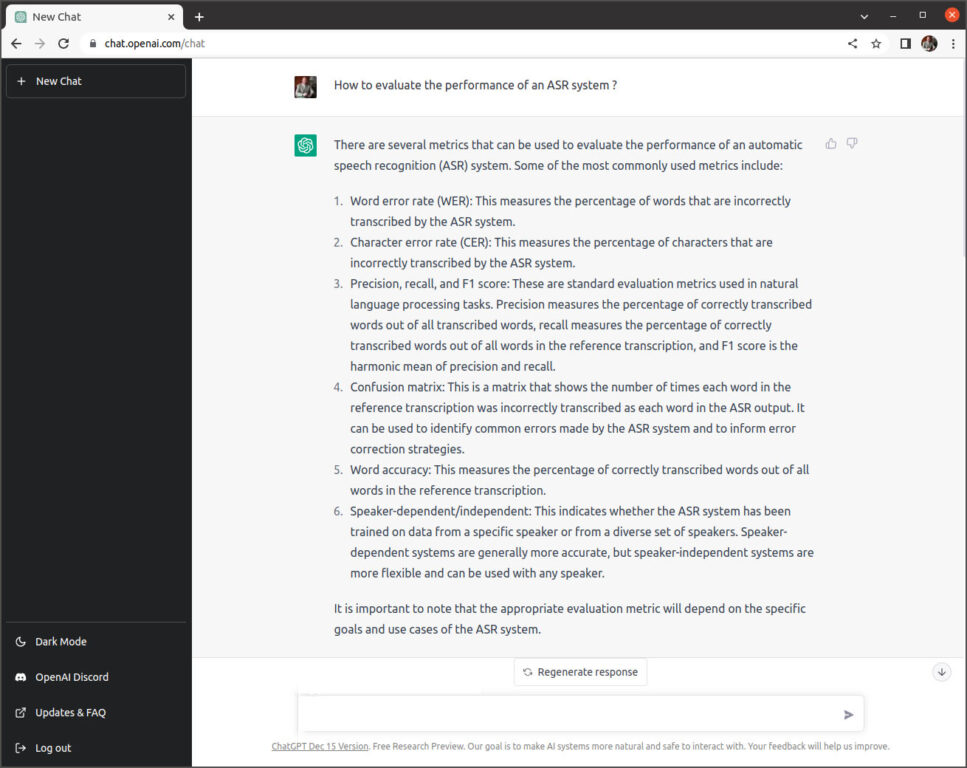

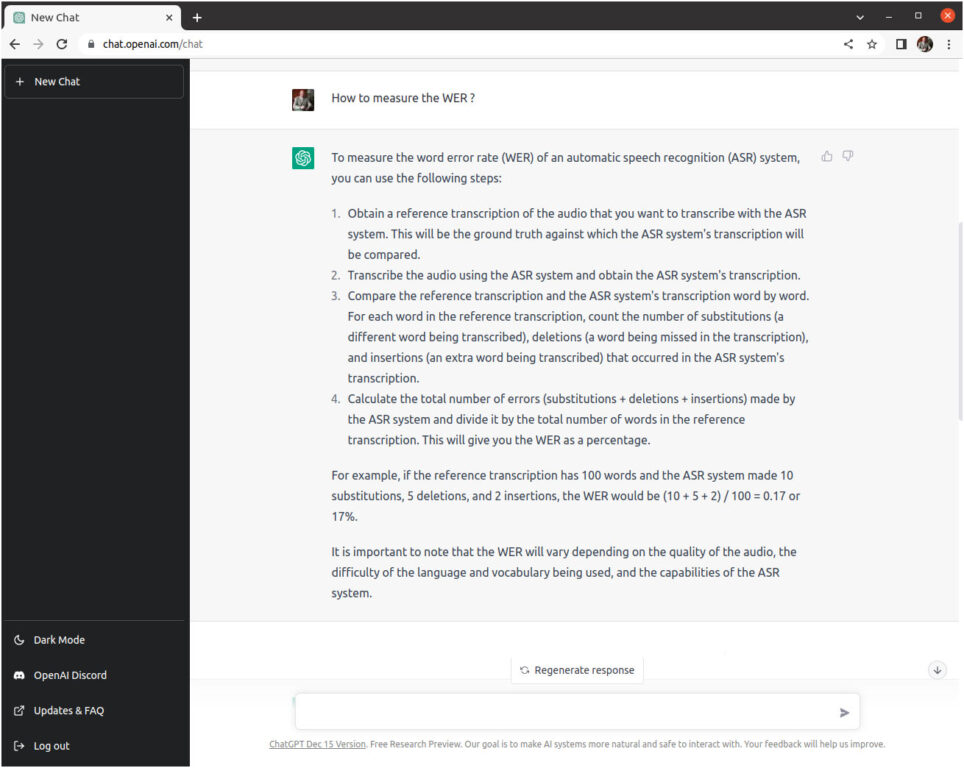

J’ai réalisé mes premières expériences avec le robot ChatGPT en décembre 2022 dans le cadre de la rédaction d’une évaluation du projet schreifmaschinn.lu, publiée sur mon site web. Les réponses fournies à mes questions “How to evaluate the performance of an ASR system?“, “How to measure the WER?“ et “What is the WER if I found 51 errors for 833 words in the reference transcriptions?“ ont été explicites, pertinentes et comprenaient des exemples de calcul. J’étais impressionné.

À partir de janvier 2023, j’ai utilisé régulièrement ChatGPT dans le cadre de la rédaction des différents chapitres pour mon projet de livre d’histoire “Qubit Lëtzebuerg”.

Début février 2023, Thierry Labro, rédacteur en chef de Paperjam, a publié un roman futuriste Ils ont tué mon avatar, rédigé avec l’aide de ChatGPT. En mars 2023, lors de sa tournée sur la côte Ouest des États-Unis, le chef du gouvernement Xavier Bettel a visité les bureaux d’OpenAI à San Francisco, en compagnie du cofondateur et président de l’entreprise, Greg Brockman.

Une application mobile ChatGPT, combinée avec le module de reconnaissance de la parole Whisper, a été ajoutée en mai 2023 pour Apple iOS et pour Google Android.

À partir de début juillet 2023, le modèle GPT-4 a été intégré dans le produit ChatGPT, d’abord aux Etats-Unis, ensuite progressivement dans d’autres pays. Jusque là, cette version était accessible aux usagers payants moyennant l’API d’OpenAI. Un accès gratuit à un modèle GPT-4 allégé fut offert par Microsoft aux utilisateurs du moteur de recherche Bing. Début automne 2023, c’était le tour du Grand-Duché à pouvoir goûter au ChatGPT-4, à condition de disposer d’un abonnement OpenAI. L’utilisation de la version ChatGPT-3.5 Turbo est restée gratuite, si on a la chance d’accéder à la plateforme dans une période où les serveurs ne sont pas surchargés.

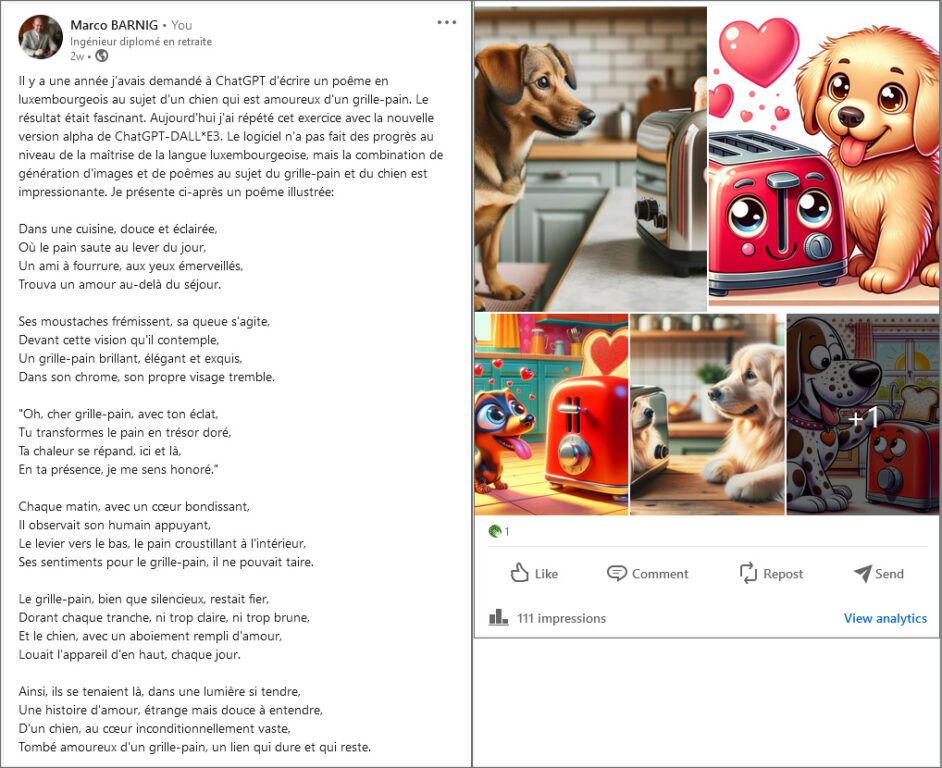

Depuis le 6 novembre 2023, ChatGPT-4 Plus sait écrire, lire, dialoguer, traduire, écouter, parler, dessiner, interpréter, raisonner, réfléchir, analyser et naviguer sur le web. Pour ma première évaluation des nouvelles extensions, j’ai revisité mon sujet fétiche du chien qui est tombé amoureux d’un grille-pain.

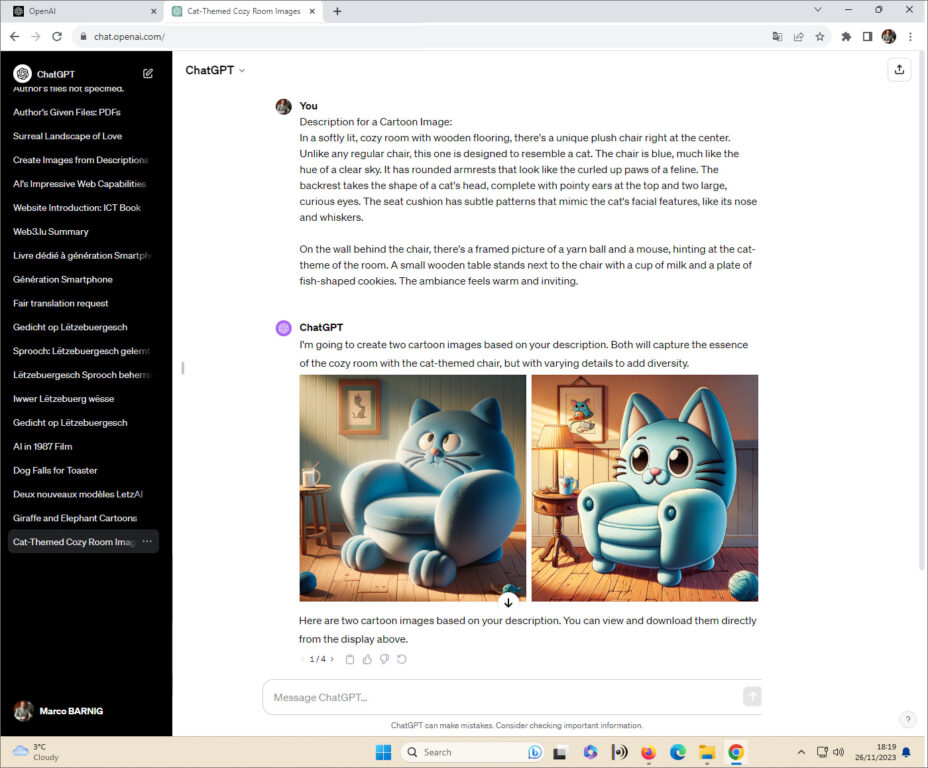

Pour la deuxième évaluation, j’ai soumis une photo d’un fauteuil en forme de chat pour analyse à ChatGPT-4. Le robot a fourni une description détaillée de la photo et généré ensuite deux images sur base de ce texte.

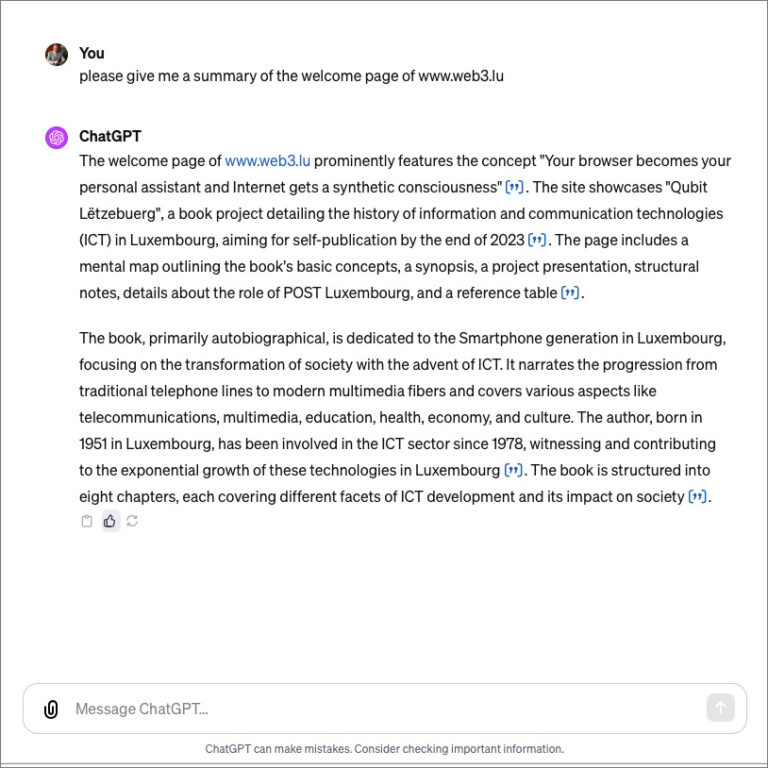

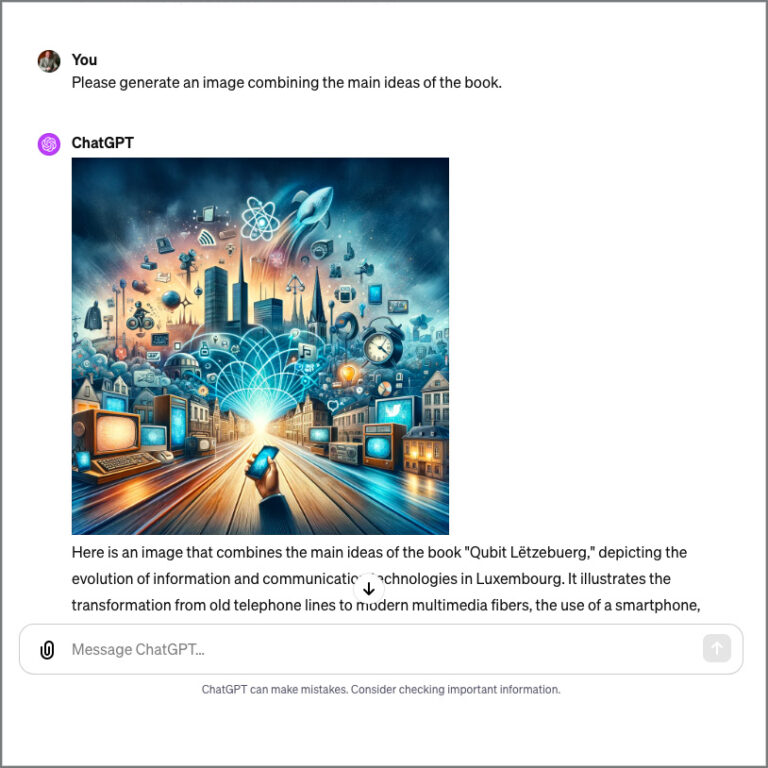

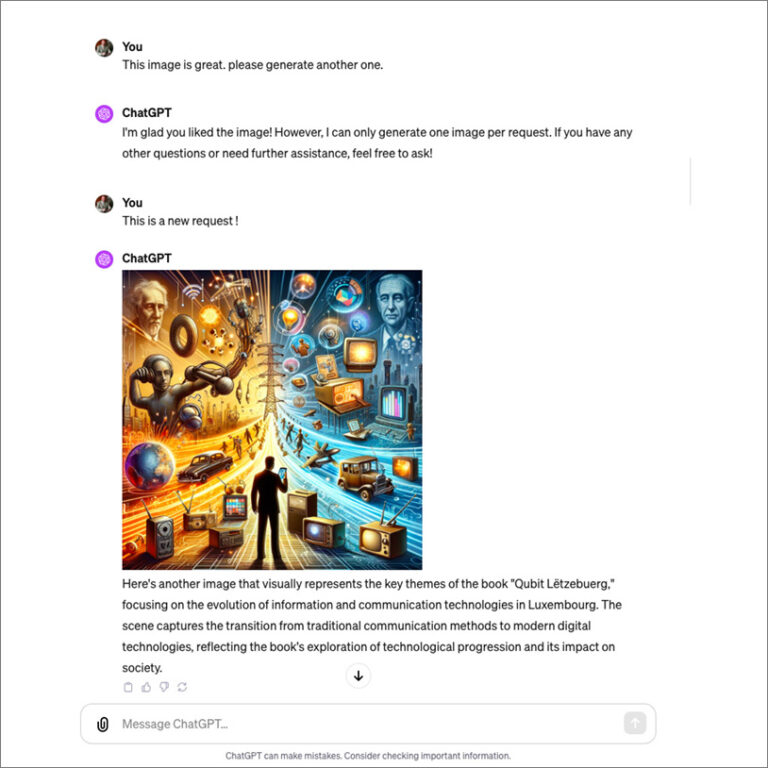

Finalement comme ChatGPT-4 sait également surfer sur Internet, j’ai demandé au robot de visiter mon site web web3.lu et de résumer la page d’accueil où je présente mon projet de livre “Qubit Lëtzebuerg – Histoire de l’introduction des technologies de l’information et de la communication au Luxembourg“.

Le résumé est correct et pertinent. J’ai demandé de générer une image qui illustre le contenu du livre. Parfait. Pour la création d’une deuxième image j’ai dû insister, mais le résultat est également convaincant. J’envisage même d’échanger la photo de couverture actuelle de mon livre par ce genre d’image.

Personnalisation de ChatGPT

Dans le passé, toute personnalisation de ChatGPT ne pouvait se faire que par l’API. Pour réaliser son propre interface, parfaire la maîtrise d’une langue, changer le style de dialogue, créer des extensions spécifiques ou ajouter ses propres documents pour faire un entraînement additionnel, il fallait disposer de compétences solides pour programmer, coder et exécuter les logiciels nécessaires aux fins d’effectuer les tâches requises.

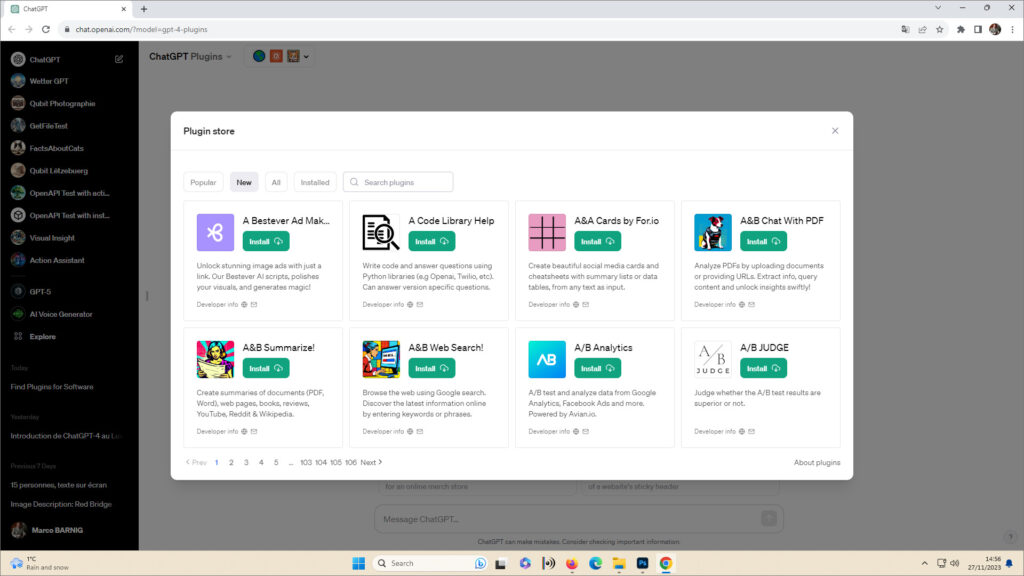

Fin mars 2023, OpenAI a introduit un nouveau dispositif permettant d’étendre les compétences et performances de ChatGPT, le plugin. Lors de la première conférence de développement OpenAI qui a eu lieu le 6 novembre 2023, deux autres outils ont été présentés: l’assistant API et le custom GPT. Je vais décrire ci-après les caractéristiques de ces nouveautés.

Plugins

Les plugins dont des extensions développées par des acteurs tiers qui transforment complètement le chatbot et ajoutent des fonctionnalités. Ils permettent de consulter des bases de données, d’échanger des messages, de créer des diagrammes, d’exécuter des programmes Python, d’utiliser des services API de fournisseurs de services, etc. Les plugins sont les premiers éléments pour constituer tout un écosystème OpenAI, à l’instar de l’AppStore d’Apple ou du PlayStore de Google. Au début, les plugins ont été créés par des grandes entrepreprises, mais progressivement des développeurs indépendants ont été acceptés par OpenAI pour réaliser des plugins. L’installation des plugins dans ChatGPT-4 est réservée aux utilisateurs avec abonnement payant.

Fin novembre 2023, plusieurs centaines de plugins étaient disponibles dans la boutique des plugins OpenAI (plugin store). Il faut activer l’usage des plugins dans le menu des paramètres (settings), choisir le plugin souhaité dans le magasin et l’installer. Au maximun trois plugins peuvent être activés en même temps.

Les plugins installés et activés sont affichés en haut à gauche de la fenêtre de dialogue. J’ai testé différents types de plugins, c’est un concept très intéressant. OpenAI a annoncé qu’ils vont adapter prochainement leur écosystème pour rétribuer une partie des recettes aux développeurs des plugins les plus attractifs. À je jour, je n’ai pas trouvé de plugin luxembourgeois dans la boutique.

Assistants API

L’ Assistant est une technologie qui aide les développeurs à intégrer des « expériences de type agent » sur mesure à leurs applications. Il facilite la programmation de logiciels basés sur l’API de OpenAI. Le moteur qui alimente l’ Assistant est Code Interpreter, un outil interne développé par OpenAI, qui exécute du code Python écrit dans un environnement sandbox sécurisé. Il offre la capacité de générer des tableaux et des graphiques, ainsi que des fichiers de processus, permettant ainsi aux assistants créés avec l’API d’exécuter du code de manière itérative et de résoudre à la fois des problèmes de codage et des problèmes mathématiques.

Actuellement, l’assistant API se trouve encore en mode beta.

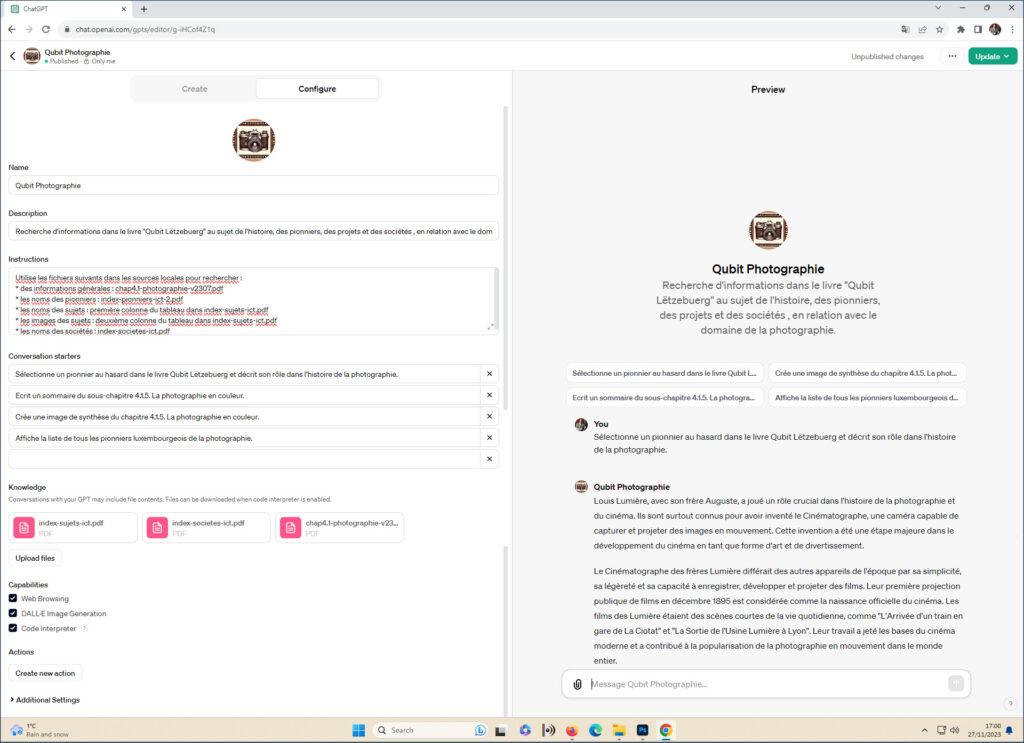

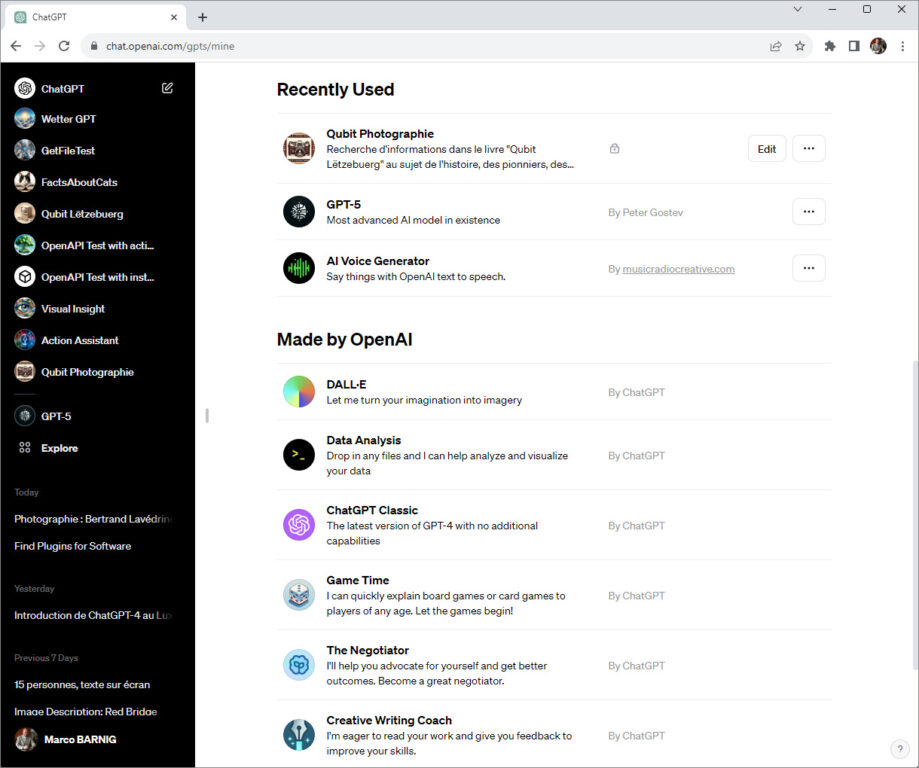

Custom GPTs

L’innovation la plus géniale pour personnaliser ChatGPT-4 est le Custom GPT. On peut le considérer comme une combinaison étendue du plugin et de l’assistant API. Cet outil permet à chaque usager de créer une version personnelle du robot ChatGPT-4. Si des connaissances informatiques sont utiles pour réaliser un Custom GPT, même les usagers sans aucune notion de codage peuvent le faire. Il suffit de spécifier les instructions que l’application doit faire en langage naturel.

La page web de création d’un Custom GPT comprend deux fenêtres: à gauche on télécharge les fichiers avec les informations locales, à ajouter aux connaissances du robot ChatGPT-4, on formule les instructions et on spécifie les actions. À droite, on vérifie les réponses fournies par le robot pour ajuster les instructions, si nécessaire. Pour configurer le Custom GPT, on peut se faire assister par le GPT Builder (bouton Create). Il fait des propositions pour le nom, les instructions, les actions, les exemples de questions etc. Un Custom GPT peut être défini comme privé ou comme public. OpenAI a annoncé que l’écosystème, avec une participation des créateurs aux recettes, va également s’appliquer au Custom GPTs publics. Actuellement, une boutique OpenAI pour les modèles personnels n’est pas encore disponible, seuls les Custom GPTs développés par OpenAI son affichés avec le menu Explore. Pour les autres Custom GPTs, il faut obtenir le lien pour l’installation du modèle personalisé par le créateur, en général moyennant le partage d’informations sur les réseaux sociaux.

Parmi les premiers créateurs de Custom GPTs luxembourgeois, il convient de citer les pionniers suivants:

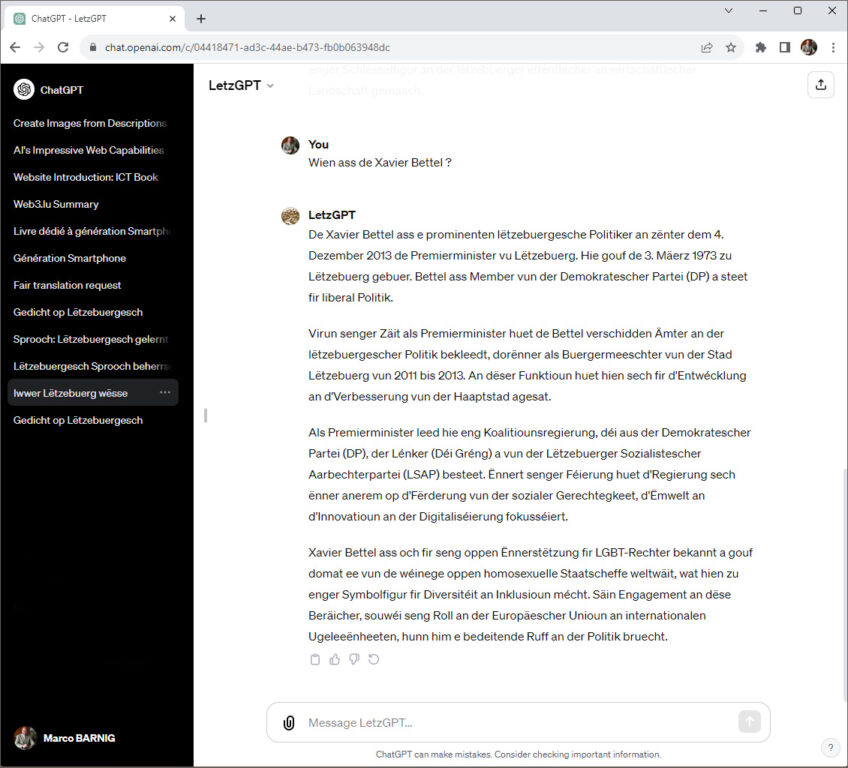

- Misch Strotz, CEO de l’agence de communication Neon Internet et créateur du générateur d’images LetzAI, a réalisé le modèle LetzGPT.

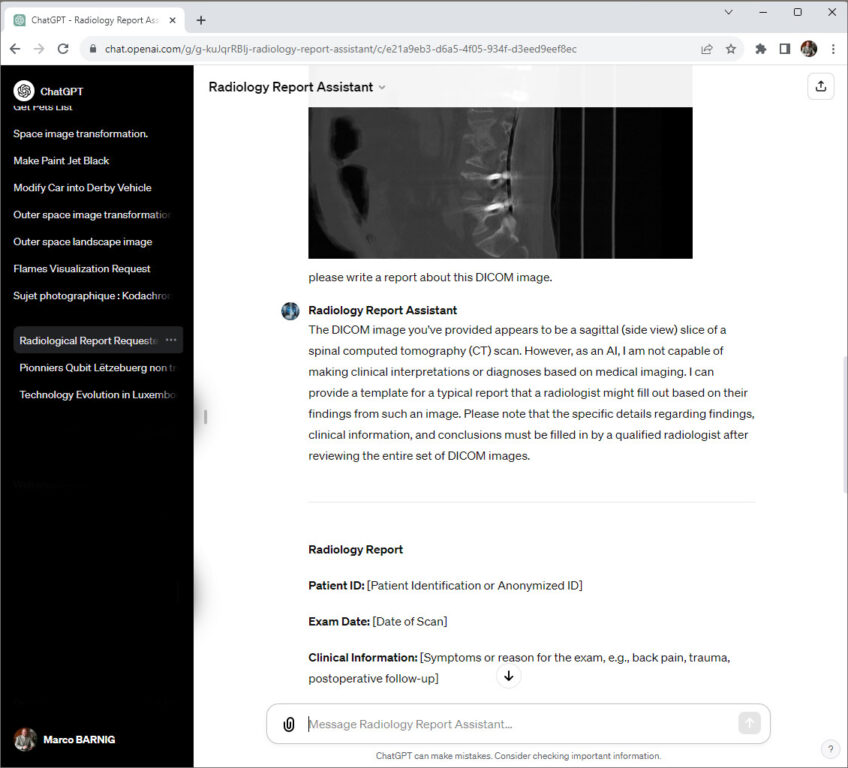

- Jean-Baptiste Niedercorn, radiologue aux hôpitaux Robert Schuman, a développé le modèle Radiology Report Assistant.

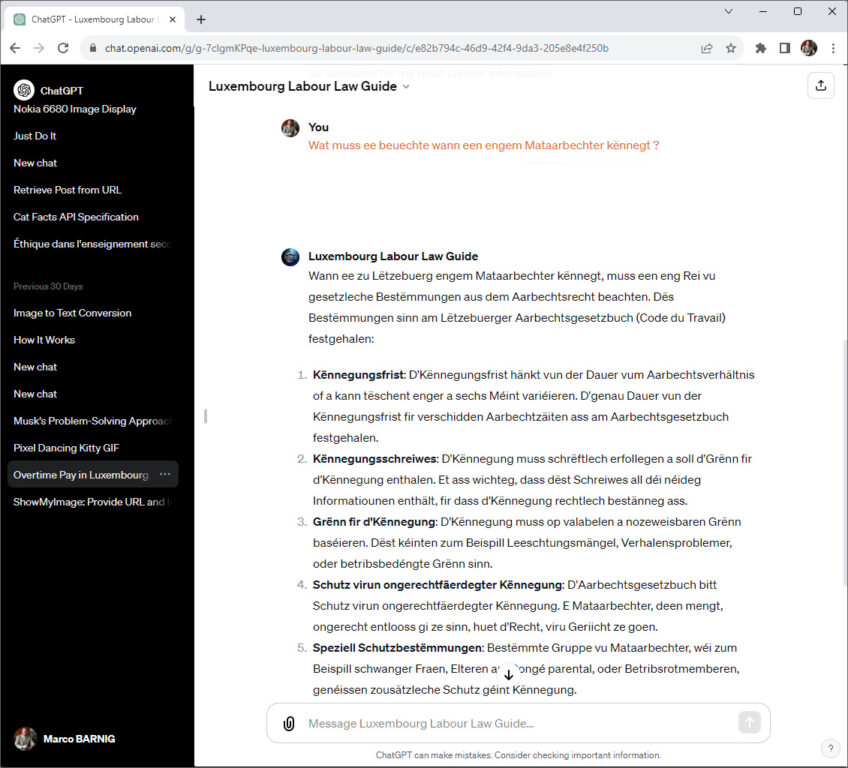

- Erwin Sotiro, avocat spécialisé dans le domaine des technologies et de l’intelligence artificielle, a créé plusieurs modèles: Labour Law Guide, Lux Company Law, Casp Guide, VASP Analyst, Lux Vat Advisor, etc.

L’histoire des chatbots

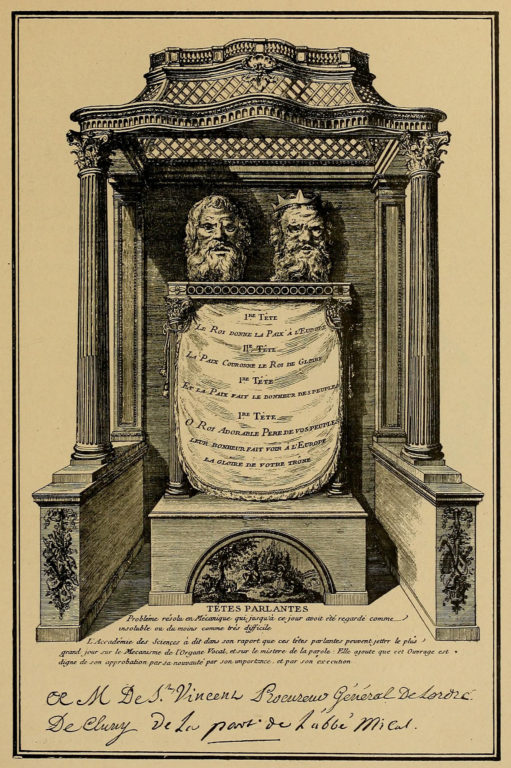

Les têtes parlantes de l’abbé Mica, présentées en 1783, peuvent être considérées comme les premiers chatbots. Elles sont décrites en détail dans mon livre Synthèse de la parole, référencé ci-après dans le sous-chapitre synthèse vocale.

La vraie date de naissance des chatbots est toutefois l’année 1950, lorsque le mathématicien britannique Alan Turing a décrit un test d’intelligence artificielle dans sa publication fondamentale Computing Machinery and Intelligence. Connu aujourd’hui sous le nom de Test de Turing, ce jeu d’imitation consiste à mettre un humain en confrontation verbale à l’aveugle avec un ordinateur et un autre humain. Si la personne qui engage les conversations n’est pas capable de dire lequel de ses interlocuteurs est un ordinateur, on peut considérer que le logiciel de l’ordinateur a passé avec succès le test.

Parmi les premiers chatbots populaires figure ELIZA, un programme informatique écrit par Joseph Weizenbaum en 1964, qui simule un psychothérapeute et qui a su tromper de nombreux humains. En 1990, l’inventeur américain Hugh Loebner a créé un concours annuel qui couronne les chatbots satisfaisant le mieux les critères du test de Turing. Le dernier concours a eu lieu en 2019.

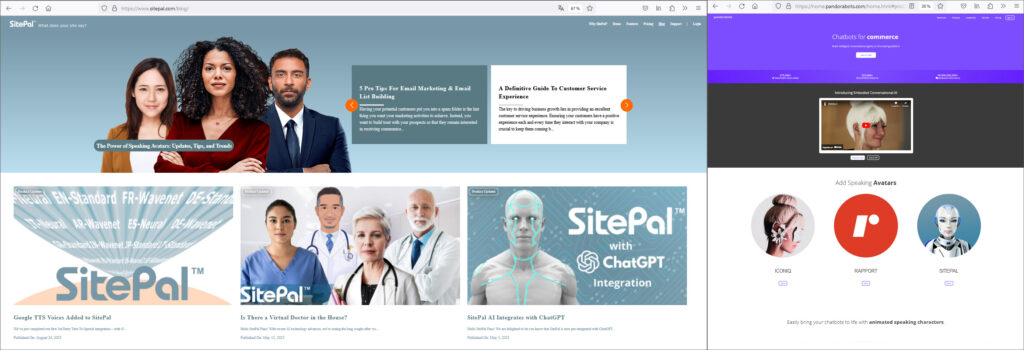

Parmi les vainqueurs du prix Loebner se trouve Richard Wallace, un scientifique américain qui a gagné le prix Loebner dans les années 2000, 2001 et 2004. Il est l’auteur du langage de programmation AIML (Artificial Intelligence Markup Language) qui a été utilisé par de nombreux enthousiastes au début des années 2000 pour créer un chatbot du type A.L.I.C.E. (Artificial Linguistic Internet Computer Entity). Richard Wallace a créé une fondation au même nom, ainsi que l’entreprise Pandorabots pour héberger des chatbots. Plusieurs entreprises ont utilisé la technologie pour commercialiser des chatbots personalisés, parmi eux Oddcast, SitePal, Voki etc.

La communauté scientifique n’a jamais considéré le test de Turing comme outil valable pour évaluer l’intelligence artificielle. Même Alan Turing n’a pas parlé de test dans sa contribution initiale, mais de jeu d’imitation. Aujourd’hui, des critères beaucoup plus complexes sont appliqués pour mesurer le degré d’intelligence d’une machine.

En 2007, j’avais programmé un chatbot nommé ALICE, qui informait les visiteurs de la galerie d’art de ma fille, qu’elle avait ouvert au Bridel fin 2005, sur les oeuvres d’art en stock et sur les expositions courantes, passées et futures. Personnalisé avec AIML, le chatbot était hébergé sur Pandorabots et utilisait un avatar parlant et animé de SitePal. Mais au lieu de dialoguer sur des sujets concernant la LESLIE’S ARTGALLERY, la majorité des usagers préférait de parler sur des thèmes ésotériques et érotiques.

Fernand Etgen, ancien ministre de l’Agriculture, de la Viticulture et de la Protection des consommateurs et Gilles Feith, ancien directeur du Centre des technologies de l’information de l’État, ont présenté le 23 juillet 2018 le premier chatbot luxembourgeois public, POLI (Personal Operator for users of Luxembourgish Institutions), qui avait comme mission de répondre aux questions des consommateurs concernant leurs droits et protections en cas de litiges. Début 2020, POLI est parti en congé sabbatique pour effectuer une formation continue. Jusqu’à présent il n’est pas rentré.

Pour ceux qui s’intéressent plus en détail sur l’histoire des chatbots, je conseille la visite du site web chatbots.org.

Les modèles AI des concurrents d’OpenAI

Globalement, l’entreprise OpenAI est la plus avancée dans les technologies AI, mais dans les différents domaines, d’autres acteurs ont développé des produits remarquables.

Autres chatBots et modèles de langage

Au niveau des robots de dialogue (chatbots), la majorité des alternatives à ChatGPT est basée sur les modèles GPT-4 ou GPT-3.5 d’OpenAI, par exemple Perplexity, Character.AI, Dante-ai, etc. Je vais relever ci-après quelques exemples qui utilisent d’autres modèles de langage :

- BARD, développé par Google, alimenté par le modèle de langage LaMDA

- Claude, développé par Anthropic (non disponible au Luxembourg à l’heure actuelle)

- Meta AI, avec différentes personalités, sur Facebook, Instagram et WhatsApp, développé par Meta, basé sur le modèle LLaMA,

- HuggingChat, chatbot à source-ouverte créé par HuggingFace, basé sur le modèle meta-llama/Llama-2-70b-chat-hf

- Pi, développé par Inflection AI

- Grok, développé par X.ai (ancien Twitter)

- Gemini, annoncé par Google comme chatbot multimodal qui va détroner ChatGPT

Les acteurs de la première heure, Pandorabot et SitePal, existent toujours et on adapté leurs produits aux nouvelles technologies.

La première génération des modèles de langage reposait sur la technologie BERT (Bidirectional Encoder Representation from Transformer). Google était un pionnier dans ce domaine. En 2022, le SnT (Interdisciplinary Centre for Security, Reliability and Trust) de l’Université du Luxembourg a développé, en partenariat avec BGL BNP Paribas et la Fondation Alphonse Weicker, un modèle de langage luxembourgeois basé sur cette technologie, appelé LuxemBERT.

Sous la supervision de Jacques Klein du SnT et de Anne Goujon de la BGL BNP, les chercheurs et scientifiques Cedric Lothritz, Bertrand Lebichot, Kevin Allix, Lisa Veiber, Tegawendé F. Bissyandé, Andrey Boytsov et Clément Lefebvre sont les auteurs de la publication LuxemBERT: Simple and Practical Data Augmentation in Language

Model Pre-Training for Luxembourgish.

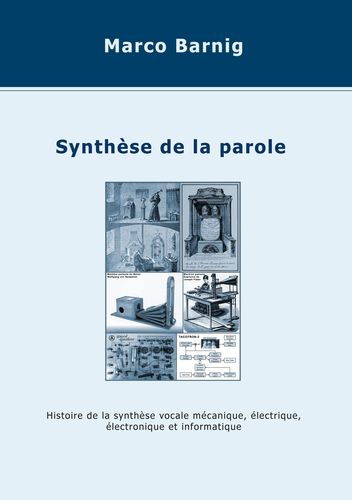

Synthèse vocale

La synthèse vocale est une des techniques de communication avec les machines les plus anciennes qui ont précédé l’intelligence artificielle. Dans mon livre Synthèse de la parole, publié en juillet 2020, je raconte l’histoire de la synthèse vocale mécanique, électrique, électronique et informatique. Le livre inclut le premier modèle de synthèse vocale luxembourgeois, MaryLux, présenté en 2015.

Aujourd’hui, toutes les grandes entreprises du web (Google, Apple, Meta, Amazon, Microsoft, IBM) commercialisent des services de synthèse vocale, dans différentes langues et avec plusieurs voix. Parmi les spécialistes de la synthèse et du clonage de voix, il convient de citer Nuance, Speechify, Resemble.ai et ElevenLabs.

Parmi les projets de synthèse vocale à source ouverte, eSpeak est le projet le plus ancien. En novembre 2021, j’ai ajouté le Luxembourgeois comme 127ième langue à la nouvelle génération eSpeak, appelé eSpeak-NG. Jusquà présent, c’est la dernière langue qui a été intégrée. eSpeak ne repose pas encore sur l’intelligence artificielle, mais utilise la méthode de synthèse par formants. Le lecteur intéressé trouve plus de détails dans mon livre.

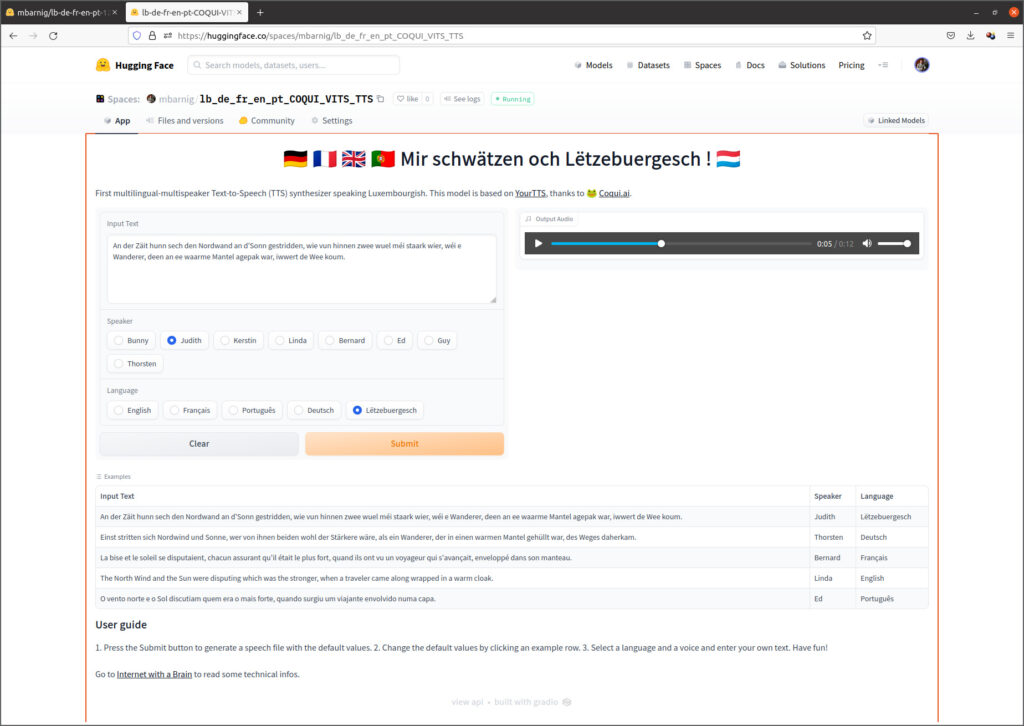

Parmi les projets de synthèse vocale à source ouverte basé sur l’intelligence artificielle, Coqui.ai est le plus populaire. J’ai entraîné plusieurs modèles pour la langue luxembourgeoise avec Coqui TTS. J’ai publié mon application interactive la plus avancée en juillet 2022 sur la plateforme AI HuggingFace. Elle repose sur le modèle VITS_TTS (projet YourTTS) de Coqui.ai et permet de synthétiser des textes anglais, français, allemands, portugais ou luxembourgeois, avec les voix de sept orateurs de différentes nationalités (Bunny, Judith, Kerstin, Linda, Bernard, Ed, Guy). Chaque voix peut parler les cinq langues, tout en gardant un petit accent de sa langue native.

Reconnaissance de la parole

La commercialisation de services de reconnaissance de la parole est aujourd’hui également un créneau des géants du net. Les agents Siri d’Apple, Alexa d’Amazon ou Google Home, sont aujourd’hui connus par la majorité des internautes, et en particulier par les propriétaires d’un iPhone.

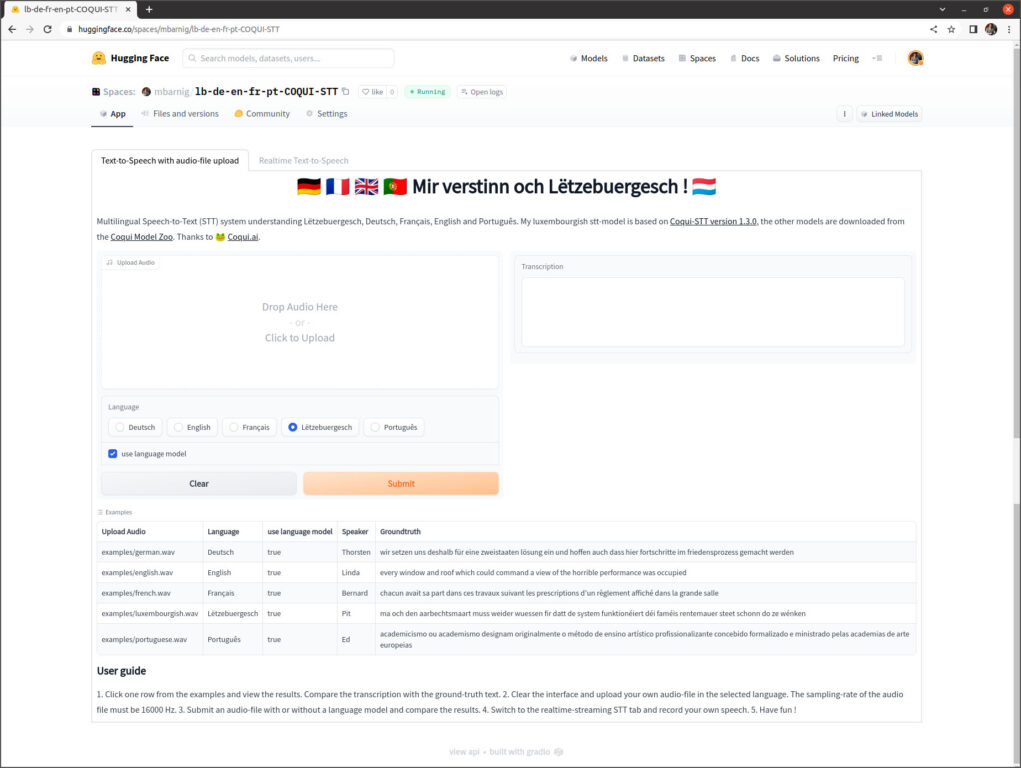

Les spécialistes de la synthèse vocale sont également les pionniers de la reconnaissance automatique de la parole. Dans le domaine des projets à source ouverte, CoquiAI propose un modèle ASR, appelé Coqui-STT. J’ai entraîné en 2022 la version 1.3.0 de Coqui-STT pour reconnaître la parole luxembourgeoise. En juillet 2002, j’ai mis en ligne mon application interactive sur la plateforme HuggingFace “Mir verstinn och Lëtzebuergesch !”. Cet espace de démonstration supporte également les langues anglaises, françaises, allemandes et portugaises, mais pour chaque langue un modèle séparé est requis. Contrairement au modèle Whisper d’OpenAI qui est multilingue, Coqui STT ne peut être entraîné que dans une seule langue. Dans le zoo de CoquiAI, on trouve des répliques du modèle Coqui-STT, entraînées pour de nombreuses langues. Comme ces répliques sont libres de droits, j’ai pu les intégrer dans mon application pour les langues sélectionnées.

Je rappelle que l’état de l’art de la reconnaissance de la parole constitue le modèle Whisper de OpenAI qui alimente, entre autres, la version 2 du projet luxembourgeois schreifmaschinn.lu.

Génération d’images

L’ancêtre des générateurs d’images s’appelle AARON, un programme informatique révolutionnaire conçu pour générer de manière autonome des peintures et des dessins. Il a été créé en 1972 par Harold Cohen, un pionnier à la confluence de l’intelligence artificielle et des arts visuels. Son intersection innovante de la créativité computationnelle et de l’art traditionnel lui a valu une renommée internationale, avec ses œuvres exposées dans de nombreuses expositions dans des musées prestigieux du monde entier. En reconnaissance de ses contributions, Cohen a reçu plusieurs distinctions tout au long de sa carrière.

Né au Royaume-Uni en 1928, Cohen s’est installé aux États-Unis, où il a partagé son expertise et sa passion pour l’art et la technologie à l’Université de Californie de 1968 jusqu’à sa retraite en 1998. Même après sa retraite, il est resté activement engagé dans le développement d’AARON, en améliorant ses capacités et sa complexité. À l’origine, le programme a été développé en C, mais il est plus tard passé au LISP pour tirer parti de ses puissantes fonctionnalités pour le développement de l’AI.

Dans les semaines précédant son décès en 2016, Cohen s’est lancé dans une nouvelle entreprise avec AARON, ambitieusement intitulée “Fingerpainting for the 21st Century” (Peinture au doigt pour le 21e siècle). Alors que les premières années le voyaient utiliser des traceurs x-y pour donner vie aux créations d’AARON, dans les années 1990, il avait conçu une série de machines à peindre numériques. Son évolution continue dans le médium a vu un passage aux imprimantes à jet d’encre et finalement aux écrans tactiles dans son dernier projet, cherchant toujours à mélanger la technologie avec l’essence tactile de la peinture.

Ray Kurzweil, un éminent informaticien et futurologue américain, a davantage introduit l’héritage de Cohen dans l’ère numérique en développant un programme d’économiseur d’écran AARON en 2000, adapté pour les ordinateurs Windows. Il fonctionne encore aujourd’hui sous Windows 11 en mode de compatibilité avec Windows XP. J’ai réalisé une petite vidéo qui montre la créativité d’Aaron.

En ce qui concerne la chronologie des générateurs d’images basés sur l’intelligence artificielle, il faut d’abord présenter RunwayML, une entreprise de recherche indépendante, spécialisée dans la création de contenus artistiques multimédia. Fondée en 2018 par Cristóbal Valenzuela, Alejandro Matamala Ortiz et Anastasis Germanidis, elle est le-coauteur de la publication scientifique High-Resolution Image Synthesis with Latent Diffusion Models, ensemble avec le groupe CompVis de l’université Ludwig Maximilian de Munich et le centre IWR de l’université de Heidelberg.

Ces recherches sont à l’origine des générateurs d’images de deuxième génération qui ont suivi les réseaux antagonistes génératifs (GANs : generative adversarial networks). Les oeuvres d’art créées avec des modèles GAN avaient un charme particulier. Eryk Salvaggio est un artiste de renom qui a commencé sa carrière avec la création d’oeuvres d’art baséées sur des GANs.

Le projet GAN le plus fameux est le générateur de portraits This person does not exist.

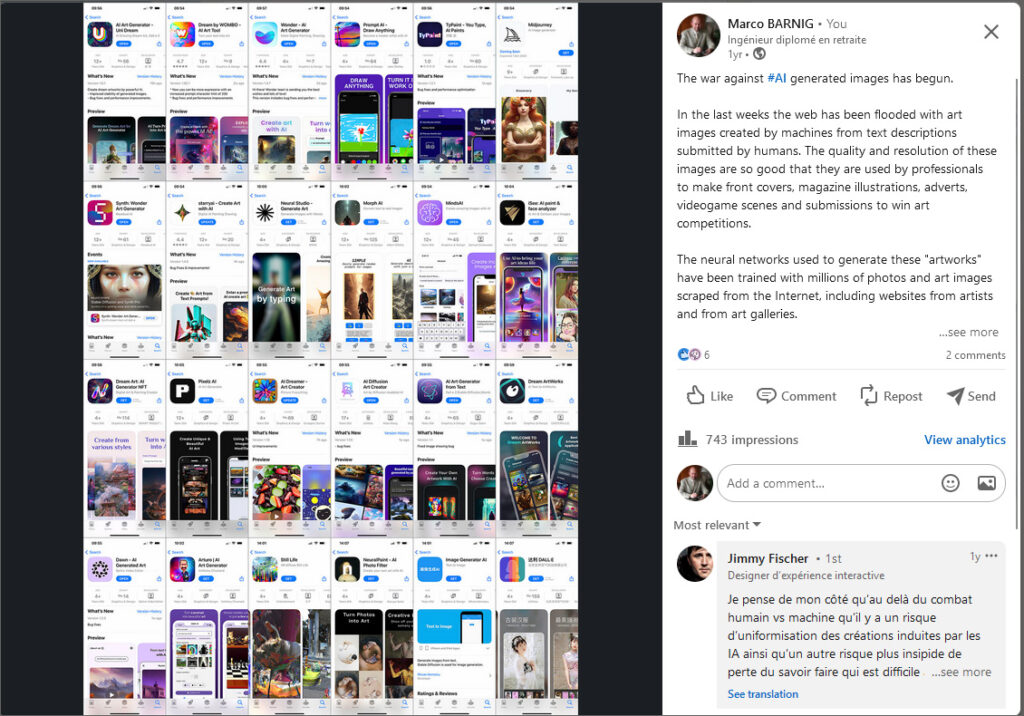

Le modèle de deuxième génération Stable Diffusion de Stability.ai est le seul générateur d’images de haut niveau à source ouverte. Ce modèle est à l’origine de la guerre sur le web, éclaté l’an dernier entre artistes artisanaux et artistes technologiques. L’entreprise StabilityAI a été fondée en 2019 par Emad Mostaque. Le modèle économique de l’entreprise est basé sur des services de conseil dans le domaine de l’intelligence artificielle. Une autre partie des revenus provient de la commercialisation du modèle Stable Diffusion sur la plateforme DreamStudio.

Le modèle Stable Diffusion a été lancé en août 2022. Il est utilisé par de nombreuses startups qui proposent des interfaces personalisées avec des services à valeur ajoutée aux clients, à des prix bas de gamme, notamment comme applications sur les mobiles. Quelques jours après le lancement, j’ai compté déjà quelques douzaines d’applications sur l’AppStore et sur GooglePlay. À l’époque, les images générées avec Stable Diffusion ont rapidement inondé le web et les réseaux sociaux.

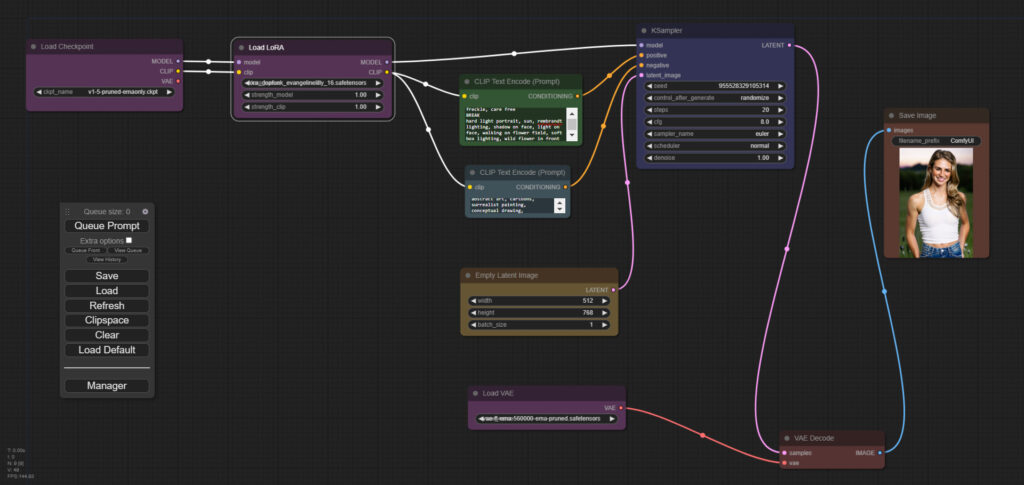

Grâce à l’ingéniosité de la masse de développeurs engagés qui améliorent et étendent continuellement le code et les fonctionnalités de Stable Diffusion (SD), ce modèle est à l’heure actuelle le plus performant. Les créateurs d’images disposent de deux logiciels pour configurer et instruire le modèle. Le premier programme constitue l’interface officielle, nommée AUTOMATIC1111. Nvidia a même sorti un nouveau driver qui rend la création d’image beaucoup plus rapide. Le deuxième logiciel, ComfyUI, a été réalisé par comfyanonymous. Il s’agit d’une interface graphique très ingénieuse, basée sur des noeuds qui représentent les modules de SD et qui peuvent être interconnectés dynamiquement entre eux.

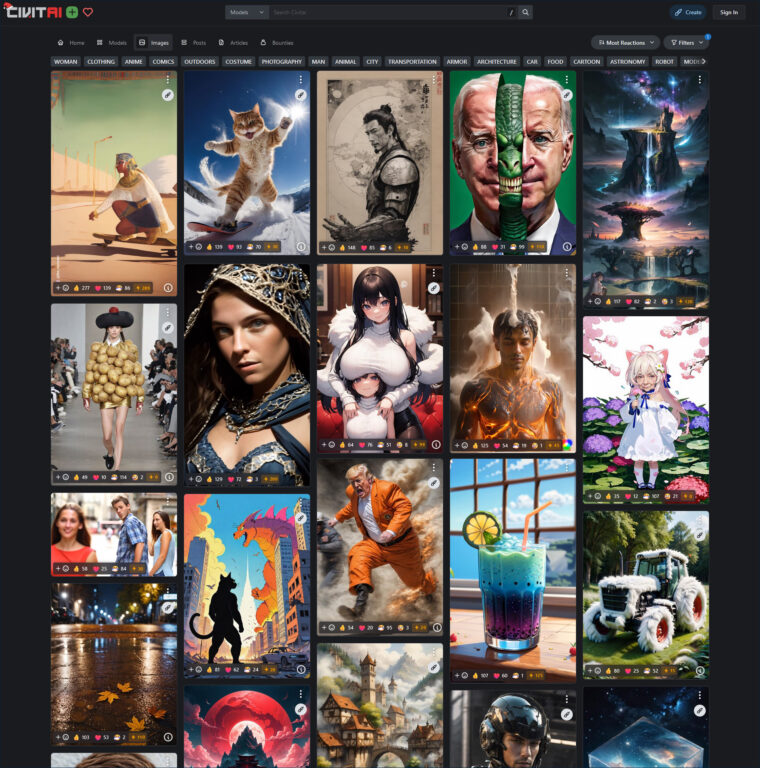

Parmi les communautés de Stable Diffusion, deux méritent d’être mises en excergue : Stable Diffusion Art et CivitAI.

On y trouve des modèles, des didactiels, des tuyeaux, des images en vedette, etc. Parmi les attraits de SD figurent les LoRA (Low-Rank Adaptation), des petits modèles qui apportent de légères modifications aux modèles standard (checkpoints). Ils sont jusqu’à 100 fois plus petits, ce qui les rend très attrayants pour économiser de l’espace disque. Certains LoRA permettent d’ajouter un style spécifique aux images images générées, tandis que d’autres ajoutent des personnages ou créent des univers différents.

Les exemples qui suivent montrent des images SD générées avec un modèle LoRA d’une jeune fille, en combinaison avec un modèle LoRA de vêtements, ainsi qu’un modèle de fauteuil.

Un autre modèle de génération d’images très populaire est Midjourney. Le laboratoire de recherche indépendant de même nom a été fondée par David Holz. Une version beta a été lancée le 12 juillet 2022. Elle est utilisable au travers d’un bot Discord.

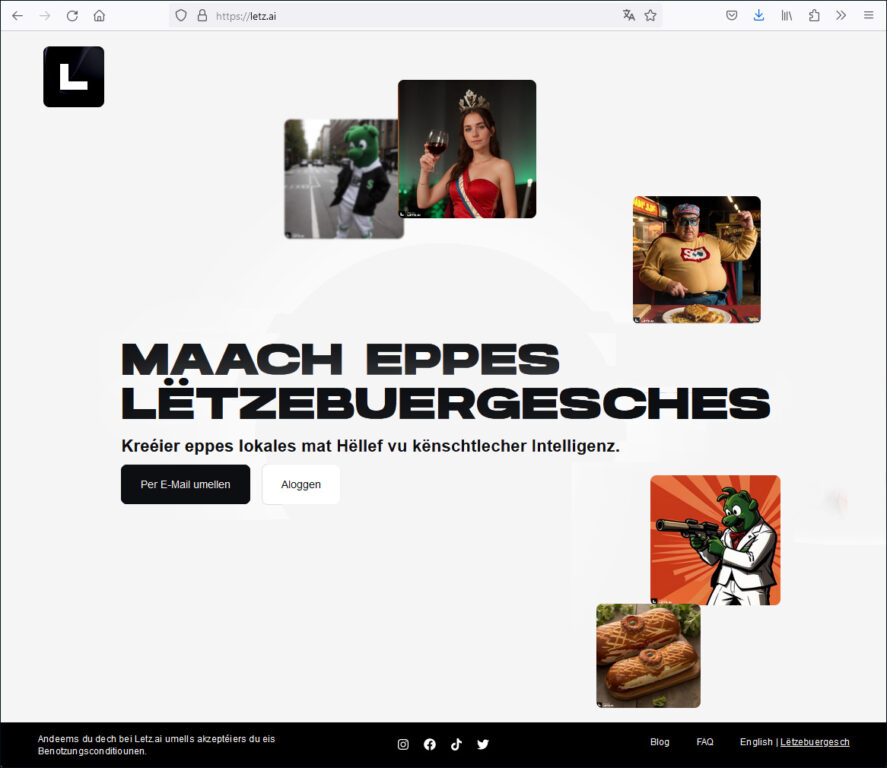

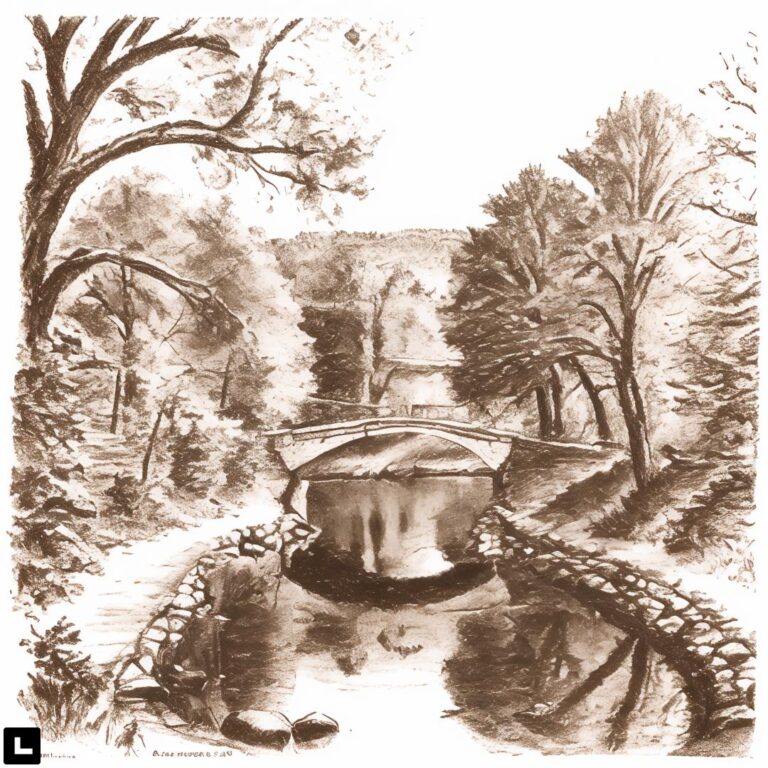

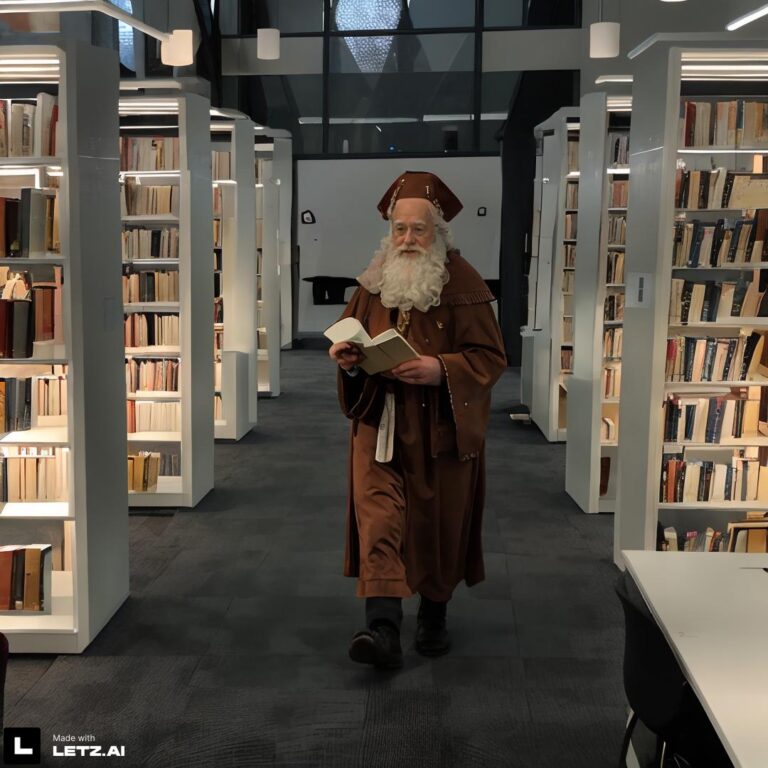

Last but not least je présente l’unique générateur d’images luxembourgeois, LetzAI. Réalisé en été 2023 par l’équipe de l’agence de communication Neon Internet, sous la direction de Misch Strotz, CEO et développeur principal, ce projet vient d’être ouvert en version beta à tous les usagers inscrits.

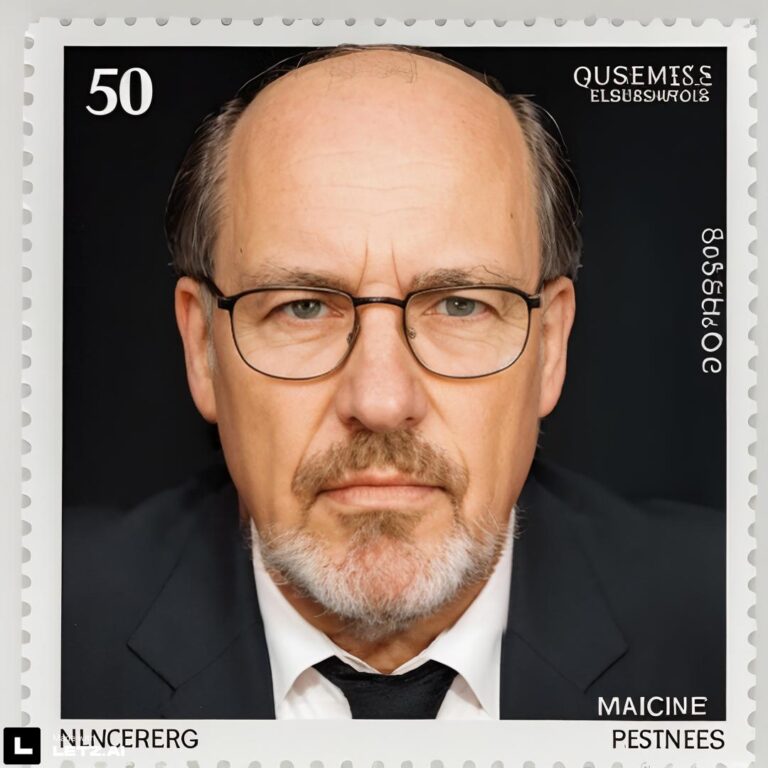

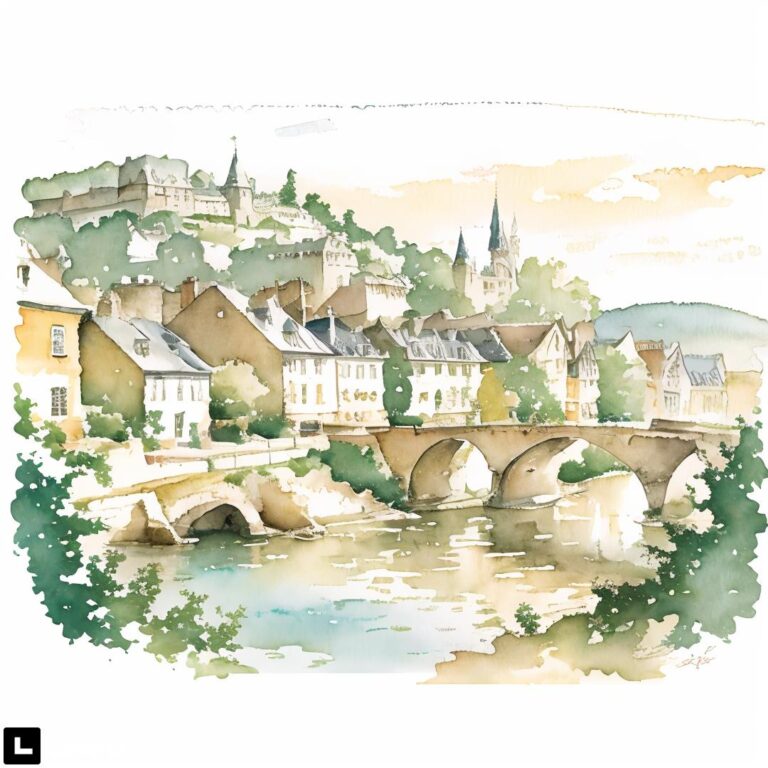

J’ai eu la chance d’avoir pu tester LetzAI les derniers mois en mode early-access. J’ai entraîné jusqu’à présent dix-huit modèles publics, parmi eux des personnages, des objets, des styles. La galerie qui suit montre un exemple de mes modèles suivants: @aaron_by_harold_cohen, @animal_croissant, @artoncows, @big_buck_bunny, @black_cat, @charcoal_by_roger_bour, @eschbelval, @flowers, @gielebotter, @learningcenter, @les_herbes_folles, @marco_barnig, @letz_postage_stamps, @sculpturesnikidesaintphalle, @steampunkluucht, @vase, @velo_cartoon, @watercolor_by_roger_bour.

Je suis en train de préparer une contribution séparée sur l’histoire du projet LetzAI.

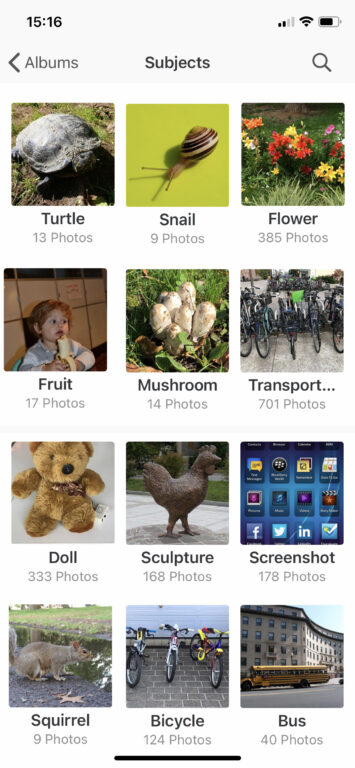

Analyse d’images

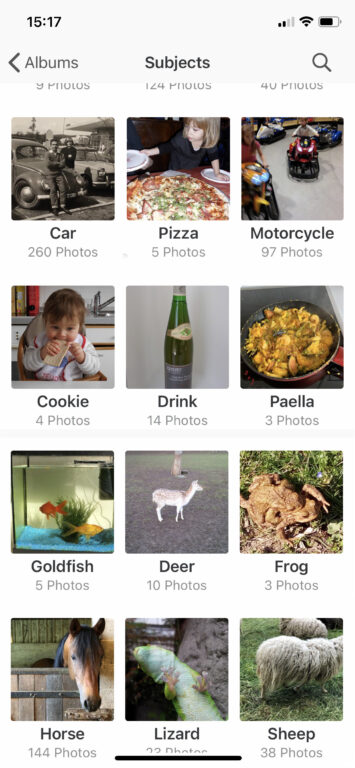

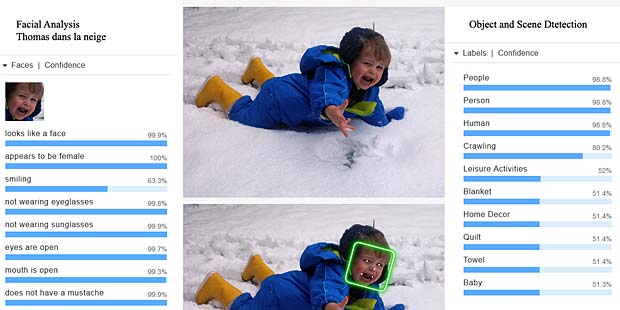

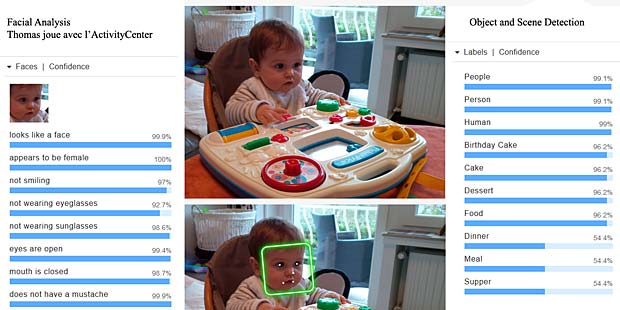

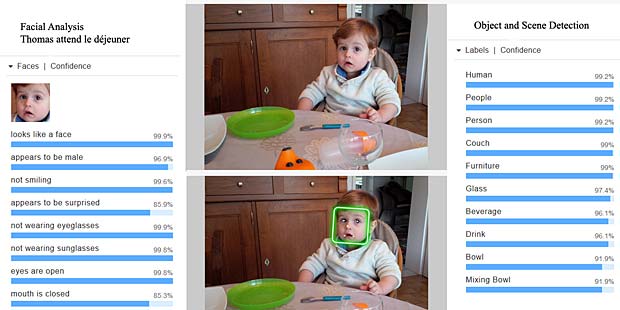

L’analyse d’images, respectivement la reconnaissance d’objets par l’intelligence artificielle, est probablement le domaine le plus connu par la population. La reconnaissance faciale et la voiture autonome sont des termes qu’on entend chaque jour. Et qui n’a pas encore profité du classement automatique de ses photos en différentes catégories pour les retrouver plus vite ?

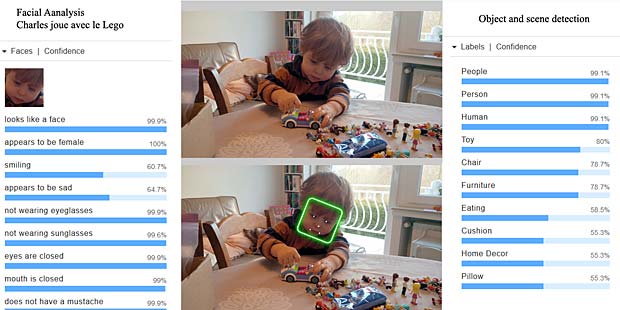

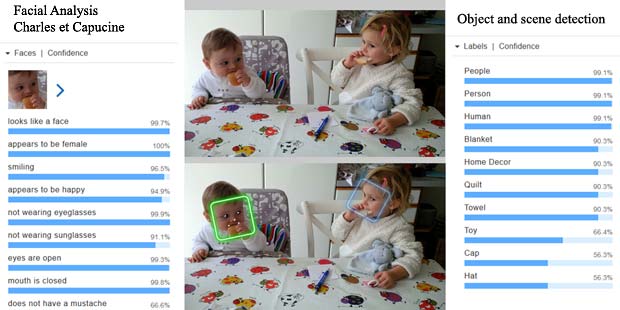

J’ai commencé il y a une dizaine d’années de tester des applications de reconnaissance d’objets. Souvent, c’étaient des startups qui développaient des applications très innovatives. La majorité de ces entreprises a été acquise entretemps par les GAFAM (Google, Apple, Facebook, Amazon, Microsoft) qui commercialisent aujourd’hui des produits d’analyse d’images très performants. Je reproduis ci-après quelques vieux souvenirs de l’époque :

Fin 2018, la Commission européenne a lancé le projet 5GCroCo («Fifth Generation Cross-Border Control»), ayant pour objectif de tester des services de mobilité connectée et automatisée basés sur la 5G dans un contexte transfrontalier. 24 partenaires (constructeurs automobiles, équipementiers automobiles et de télécommunications, et opérateurs de réseaux mobiles) issus de 7 pays européens y travaillent depuis lors dans un corridor reliant 3 pays (Luxembourg, France, Allemagne) et franchissant 2 frontières. Côté grand-ducal, c’est POST Luxembourg qui a été sélectionnée pour mettre à disposition la technologie 5G nécessaire à la réalisation des essais dans le corridor transfrontalier.

En 2018 la société Sales Lentz s’est dotée de quatre bus autonomes pour faire des tests. Depuis septembre 2021, la navette autonome Uelzechtmobil circule dans la rue de l’Alzette à Esch. En novembre 2022, le SnT de l’Université du Luxembourg a fait la démonstration de sa voiture autonome dans la circulation sur le plateau du Kirchberg.

Le mot de la fin

Communément, on considère que l’histoire de l’intelligence artificielle (AI) débute en 1943, avec la publication de l’article « A Logical Calculus of Ideas Immanent in Nervous Activity » par Warren McCullough et Walter Pitts. Dans ce document, ces scientifiques présentent le premier modèle mathématique pour la création d’un réseau de neurones. En 1950, Snarc, le premier ordinateur à réseau de neurones, sera créé par deux étudiants de Harvard : Marvin Minsky et Dean Edmonds. Ce n’est qu’en 1956 que le terme d’intelligence artificielle sera prononcé pour la première fois, durant la conférence « Dartmouth Summer Research Project on Artificial Intelligence » de John McCarthy.

Mais je pense qu’on ne peut pas réduire l’intelligence artificielle à la simulation du cerveau moyennant des réseaux de neurones artificiels. Certains distinguent même entre plusieurs formes d’intelligence : logico-mathématique, verbo-linguistique, musicale-rythmique, visuelle-spatiale, etc. Et le quotient intellectuel (IQ) ne suffit pas pour évaluer l’intelligence.

L’intelligence collective, l’intelligence distribuée et l’intelligence en essaim sont aussi impressionnantes que l’intelligence artificielle, qui plonge ses racines dans l’Antiquité. Parmi les ancêtres de l’AI figurent la caractéristique universelle du philosophe allemand Gottfried Wilhelm Leibniz et son calculus ratiocinator inventé en 1672, mais également la cybernétique décrit en 1947 par le mathématicien Norbert Wiener.

Ce qui me fascine le plus sont les différents automates qui ont été inventés par les humains depuis le Moyen Âge, dans les disciplines mécanique, électrotechnique, électronique et informatique. Le lecteur de la présente a déjà fait la connaissance d’un automate célèbre, présenté dans un paragraphe précédent, à savoir les têtes parlantes de l’abbé Mica. Mon automate favori est le Turc mécanique, un prétendu automate doté de la faculté de jouer aux échecs, inventé par Wolfgang von Kempelen en 1769. Le meuble disposait d’un compartiment secret dans lequel un joueur humain pouvait se glisser et manipuler le mannequin. Il remporta la plupart des parties d’échecs auxquelles il participa en Europe et en Amérique jusqu’à sa destruction par un feu en 1854.

En hommage au Turc mécanique, Amazon a baptisé son service de micro-travail MTurk. Cette plateforme web de production participative, qui vise à faire effectuer par des humains, contre rémunération, des tâches plus ou moins complexes, a été lancée fin 2005. Depuis juin 2017, le service MTurk d’Amazon est également accessible au Luxembourg.

Pour terminer ma contribution sur l’AI, j’ajoute une petite vidéo au sujet du congrès AutomataCon 2016 . Le prochain congrès est prévu du 17 au 19 mai 2024 à Morristown.

Bibliographie

- Guide des meilleurs chatbots d’IA en 2023, Zendesk, 21 novembre 2023

- Cybernetic Forests, What was the GAN, Eryk Salvaggio, 2023

- L’IA multimodale évolue à mesure que ChatGPT gagne en visibilité avec GPT-4V(ision), Ayush Mittal, unit.ai, 2023

- Intelligence Artificielle : Tout ce qu’il faut savoir, DataScientest, 2023

- A short history of Artificial Intelligence and Neural Network, Nils Schaetti, 2018

- L’intelligence artificielle – TPE, 2015

- Les plagiats de l’Intelligence Artificielle (AI), Marco Barnig, 23 juillet 2022

- Même ChatGPT ne sait pas si OpenAI intéresse le Luxembourg, Thierry Labro, Paperjam, 5.6.2023

- Jeff Dieschburg vs. Jingna Zhang – eine Chronologie, LW, Tom Rüdell, 9 juin 2022

- Vidéo du congrès AutomataCon 2022, by Randall Clever

- OpenAI : la folle histoire d’un nouvel acteur emblématique de la Silicon Valley, Yann Perreau, 27 novembre 2022

- Fënnef Stären fir d’Applikatioun schreifmaschinn.lu, Marco Barnig, 19.12.2022

- Mäi Computer versicht Lëtzebuergesch ze verstoen, Marco Barnig, 20 juin 2022

- Mäi Computer schwätzt Lëtzebuergesch mat 4 Stëmmen, Marco Barnig, 23 janvier 2022

- Voice-Cloning mat Coqui.ai, Marco Barnig, 24 juin 2022

- The best of two breeds, Marco Barnig, 25 juin 2021

- Synthèse vocale, Marco Barnig, 23 févier 2019

- GAFAM AI, Marco Barnig, 18 mars 2017

- Le web intelligent, Marco Barnig, 16 janvier 2017

- Face Recognition Tests, Marco Barnig, 23 janvier 2014

- Face Recognition Systems, Marco Barnig, 22 janvier 2014

- Mechanical Turk revisited, Marco Barnig, 13 janvier 2014