Première publication : 21 janvier 2018

Dernière mise à jour : 26 mars 2021

1. Introduction

Si quelqu’un vous dit qu’un Furby a une sorte de conscience comme les humains vous allez rire. Mais il ne s’agit pas d’une blague. L’étude de la conscience n’est devenue un domaine scientifique à part entière que depuis une trentaine d’années, tandis qu’elle relevait dans le passé surtout de la philosophie, de la métaphysique et de la religion.

La recherche sur le phénomène de la conscience a été longtemps négligée sur le plan scientifique dans les universités, faute d’outils conceptuels et expérimentaux. Grâce aux progrès des neurosciences, de l’imagerie cérébrale, des analyses statistiques d’activités cérébrales et l’étude de cas particuliers où les états de consciences sont altérés en raison de lésions cérébrales, les premières théories scientifiques de la conscience ont été présentées récemment.

Le fondement de ces théories a été posé par Francis Crick et Cristof Koch en 1990 dans un article intitulé Vers une théorie neurobiologique de la conscience, publié dans le volume 2 des séminaires en Neurosciences.

Francis Crick était un biologiste britannique qui a reçue le Prix Nobel de physiologie ou médecine en 1962 pour la découverte de la structure de l’ADN, ensemble avec James Watson et Maurice Wilkins.

Christof Koch, un étudiant de Francis Crick, est aujourd’hui un des neuroscientifiques les plus renommés de la planète. Ancien professeur au Caltec (California Institute of Technology), il est actuellement le président et chercheur principal au Allen Institute for Brain Science. Cet institut a été fondé en 2003 par le milliardaire Paul Allen, le co-fondateur de Microsoft. Avec plus de 300 employés et doté de moyens technologiques faramineux, c’est un des laboratoires de recherche sur le cerveau les plus importants du monde et constitue une référence dans les neurosciences.

Mais avant d’entrer dans les détails des nouvelles théories de la conscience, il convient de se mettre d’accord ce qu’on entend par conscience (consciousness en anglais).

2. La Conscience

La définition et la localisation de la conscience constituent encore un énigme scientifique. Quelle est cette vie intérieure, cette subjectivité, ce regard que l’on porte sur le monde et sur soi.

Le fondateur de la philosophie moderne, René Descartes (1596 – 1650), distinguait le corps et l’esprit (l’âme). Il proclamait que les deux substances se rencontrent chez l’homme dans la glande pinéale. Descartes ne parlait pas encore de conscience, ce terme est postérieur à lui.

Aujourd’hui, en biologie, la conscience regroupe le sens de l’éveil (wakeness), la connaissance de soi (awareness) et la perception de l’environnement. Depuis quelques années il y a une clarification conceptuelle :

- la conscience primaire : elle renvoie tout simplement au fait de ressentir quelque chose : le goût du chocolat, la chaleur, la douleur ; ces impressions subjectives qui émanent du monde extérieur sont appelées qualia

- la conscience réflexive : elle nous projette dans l’avenir

- la conscience de soi : c’est la forme la plus complexe

Les qualia sont donc les propriétés de la perception et généralement de l’expérience sensible. On distingue :

- les expériences perceptives

- les sensations corporelles : douleur, faim, fatigue, chaleur, ..

- les affects : sentiments, émotions, passions, …

On attribue quatre propriétés aux qualia :

- ils sont ineffables, on ne peut les communiquer, ni les appréhender autrement que par expérience directe

- ils sont intrinsèques ou immédiats : ce ne sont pas des propriétés relationnelles

- ils sont privés : toute comparaison interpersonnelle est impossible

- ils sont appréhendés directement par la conscience

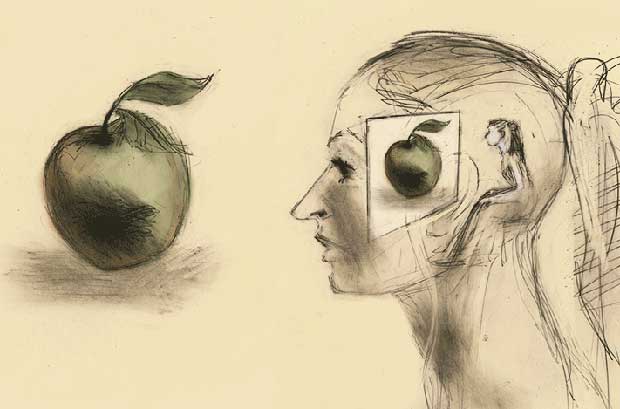

Le modèle classique de la conscience consiste à la décrire comme un petit “moi”, un homoncule (petit homme), assis dans notre tête, qui regarde ce qui se passe dans le monde, comme un spectateur qui regarde un film. Bien que cette métaphore est une des plus intuitives de la conscience humaine, elle a de nombreuses failles. Les neurosciences modernes ont mis en évidence qu’il n’y a pas de centre de contrôle spécifique dans le cerveau qu’on peut assimiler à ce homoncule. Le philosophe Daniel Dennett, un farouche opposant à ce modèle qu’il appelle le théâtre cartésien, soutient que cette approche conduit directement à ce qu’on appelle une régression à l’infini.

Une autre approche pour cerner le phénomène de la conscience est la tentative de le définir par la négative. Quand on ferme les yeux, on perd l’expérience visuelle consciente. Quand on est sous anesthésie, c’est la conscience de la douleur qui disparaît. Quand on s’endort, c’est plus compliqué. Nous avons souvent conscience de nos rêves qui sont vécus comme une expérience intense. Même pendant le sommeil profond, on ne perd pas totalement conscience, car ont entend son enfant pleurer même durant cette période. Les personnes souffrant de la maladie d’Alzheimer perdent progressivement la conscience et ne sont plus sûres de leur propre identité. Les personnes qui sont dans le coma, après un traumatisme cérébral, ne manifestent plus aucune activité consciente.

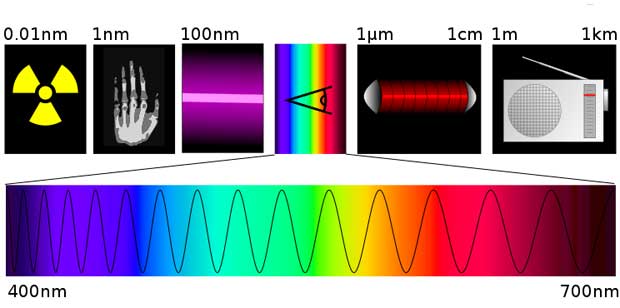

Si nous essayons de définir la conscience d’une façon positive, on se heurte au problème qu’une expérience consciente n’est accessible qu’à la personne qui l’expérimente et que celle-ci a des difficultés d’exprimer avec clarté et fiabilité le contenu de son expérience subjective. Comment communiquer à autrui quelle sensation on éprouve en regardant la couleur d’une fraise ? Il n’y a pas de couleurs dans la nature, seulement des rayonnements électromagnétiques et des réfractions. Les couleurs n’existent que dans nos têtes.

Aujourd’hui il y a presque unanimité parmi les scientifiques de toutes les disciplines que la conscience est liée à l’ensemble des neurones du cortex cérébral, la substance grise périphérique des hémisphères cérébraux et qu’elle dépend de la manière de transmission et de traitement des informations dans le cerveau. Un assemblage particulier des neurones fait émerger la conscience.

Pour ce faire une idée de la complexité du cortex cérébral nous allons comparer l’ordre de grandeur du nombre de neurones dont disposent les humains et autres organismes vivants.

3. Assemblages de neurones biologiques

Le tableau suivant présente le nombre de neurones estimé pour quelques organismes vivants spécifiques. Il s’agit d’ordres de grandeur qui proviennent essentiellement de Wikipedia. Dans le passé, le nombre total de neurones a surtout été considéré comme un indice d’intelligence d’un organisme.

| organisme vivant | nombre total de neurones | nombre de neurones dans le cortex cérébral | nombre de synapses |

| éponge | 0 | – | 0 |

| ver | 302 | – | 7.500 |

| méduse | 5.600 | – | ? |

| escargot | 11.000 | – | ? |

| mouche | 250.000 | – | 10.000.000 |

| abeille | 960.000 | – | 1.000.000.000 |

| grenouille | 16.000.000 | – | ? |

| souris | 71.000.000 | 4.000.000 | ? |

| rat | 200.000.000 | 18.000.000 | 448.000.000.000 |

| pigeon | 310.000.000 | 72.000.000 | ? |

| poulpe | 500.000.000 | – | ? |

| chat | 760.000.000 | 250.000.000 | 10.000.000.000.000 |

| corbeau | 2.171.000.000 | 1.200.000.000 | ? |

| chien | 2.253.000.000 | 530.000.000 | ? |

| singe (rhésus) | 6.376.000.000 | 1.710.000.000 | ? |

| gorille | 33.400.000.000 | 9.100.000.000 | ? |

| baleine | ? | 15.000.000.000 | ? |

| humain | 86.000.000.000 | 16.800.000.000 | 150.000.000.000.000 |

| éléphant | 257.000.000.000 | 5.600.000.000 | ? |

| dauphin | ? | 37.200.000.000 | ? |

Bien que l’intelligence n’est pas qu’une seule affaire du nombre de neurones, mais qu’il faut également considérer le pourcentage de la masse du cerveau sur celle du corps ainsi que le quotient d’encéphalisation, l’analyse des chiffres confirme toutefois certaines observations faites par des biologistes :

- les abeilles sont plus intelligents que les mouches, les rats sont plus intelligents que les souris, les chiens sont plus intelligents que les chats

- les poulpes et les corbeaux sont des animaux ayant une intelligence impressionnante

- les dauphins ont une intelligence proche de celle des humains

- les éléphants disposent d’un nombre total de neurones quatre fois plus élevé que les humains, mais ils ont trois fois moins de neurones dans le cortex cérébral

Le nombre de neurones dans le cortex cérébral n’est pas seulement un indicateur pour le degré d’intelligence, mais également un indicateur pour le degré de conscience.

En 2012 a eu lieu à l’Université de Cambridge, UK, la première conférence à la mémoire de Francis Crick. A cette occasion un groupe de neuroscientifiques, parmi eux Christof Koch, a signé une déclaration au sujet de la conscience animale.

Nous allons maintenant examiner comment mesurer le degré d’intelligence et de conscience d’un organisme vivant.

4. Les tests d’intelligence et de conscience

Les tests du quotient d’intelligence (IQ) pour les humains sont bien connus et utilisés en pratique depuis longtemps.

En ce qui concerne l’intelligence articielle, on utilise un test fondé sur la faculté d’une machine à imiter la conversation humaine, décrit par Alan Turing en 1950 dans sa publication Computing machinery and intelligence. Le Test de Turing consiste à mettre un humain en communication à l’aveugle avec un ordinateur et avec un autre humain, moyennant l’échange de messages textuels. Si la personne qui engage les conversations n’est pas capable de dire lequel de ses interlocuteurs est un ordinateur, on peut considérer que le logiciel de l’ordinateur a passé avec succès le test.

Une compétition annuelle, initiée en 1990 par Hugh Loebner, décerne annuellement le prix Loebner aux agents conversationnels satisfaisant le mieux les critères du test de Turing.

Aujourd’hui, le test de Turing est dépassé. Il convient pour une intelligence artificielle (AI) algorithmique verbale du type AIML, développée par l’informaticien Richard Wallace. Même l’intelligence artificielle générale (AGI) est remplacée par l’apprentissage profond (deep learning) qui fait partie d’une famille de méthodes d’apprentissage automatique de modèles de données, proche de l’apprentissage humain. Aujourd’hui personne ne conteste que l’AI dépasse l’intelligence des humains dans de nombreux domaines spécifiques. Un exemple récent curieux est celui du robot chinois Xiaoyi qui a réussi un concours de médecine en août 2017, outrepassant les performances moyennes des étudiants.

[sta_anchor id=”moments” /]D’ailleurs aujourd’hui chacun d’entre nous peut se convaincre lui-même des performances de l’intelligence artificielle, soit en testant les services intelligents en ligne GAFAM du web intelligent, soit en utilisant une application intelligente, comme le logiciel de gestion de photos Synology Moments ou Google Photos, ou encore l’outil de dessin en ligne AutoDraw, développé par Google Creative Lab. Ceux qui ont des compétences techniques peuvent créer leurs propres applications intelligentes avec des logiciels d’apprentissage profond, mis à disposition en libre source par les sociétés GAFAM, comme la librairie TensorFlow, hébergée sur la plateforme GitHub.

Au niveau des test de la conscience biologique on utilise le test du miroir pour évaluer la reconnaissance de son propre corps. Le test consiste à placer sur la tête d’un animal, pendant son sommeil, une marque colorée ne produisant pas d’odeur. Lors de son réveil, on examine si l’animal réagit d’une façon indiquant qu’il reconnait que la tache est placée sur son propre corps, quand il voit son image dans un miroir.

A partir de 18 mois un enfant est généralement capable de reconnaître son corps. Les animaux qui réussissent le test du miroir sont :

- les bonobos, chimpanzés, orang-outans et gorilles

- les dauphins et certaines espèces d’orques

- les éléphants d’Asie

- certaines espèces de corbeaux, de perroquets et de pies

Pour tester la conscience synthétique, quelques chercheurs utilisent également le test du miroir pour évaluer des robots. En 2008 Giulio Tononi et Christof Koch contribuaient à l’édition spéciale THE SINGULARITY du journal IEEE Spectrum avec la publication de l’article “Can Machines Be Conscious ? Yes – and a new Turing test might prove it”. Trois ans plus tard, les mêmes auteurs ont publié dans Scientific American l’article A Test For Consciounsness qui fournit plus de détails sur le nouveau test de Turing. Si une machine est capable de reconnaître que des scènes fantaisistes, présentées dans des images ou vidéos (par exemple des vaches volantes ou des éléphants avec une tête de chien), ne correspondent pas à la réalité, sans apprentissage profond au préalable, on peut dire que la machine est consciente. Ces deux contributions ont suscité de vives réactions et de nombreux commentaires auprès de la communauté scientifique.

Guilo Tononi est professeur de psychiatrie et de neurosciences à l’Université du Wisconsin à Madison, chef du Centre du Sommeil et de la Conscience (CSC). Il a été formé par Gerald Edelman, biologiste américain qui a obtenu le prix Nobel de médecine en 1972, ensemble avec Rodney Porter, pour ses recherches sur les anticorps.

Jusqu’à présent nous avons fait connaissance avec quelques acteurs et institutions clés du domaine de la conscience. Il convient maintenant d’élargir notre horizon et de passer en revue l’ensemble des projets de recherche d’envergure sur le cerveau.

5. Les projets de recherche d’envergure sur le cerveau

Vers le milieu du XXe siècle, des chercheurs dans différents domaines comme la neurobiologie, les mathématiques, l’informatique, la psychologie, l’anthropologie et la linguistique, ont commencé à mettre en commun leurs idées, ce qui a conduit à la naissance d’une nouvelle science interdisciplinaire, appelé les sciences cognitives. Les psychologues y apportaient leurs anciens modèles, comme le structuralisme (introspection) et le béhaviorisme, pour décrire l’esprit humain. L’échange fructueux des idées a déclenché un nouveau courant de pensée appelé cybernétique. Cette discipline s’intéressait à la façon dont circule l’information tant chez les être vivants que dans les systèmes informatiques.

A la fin des années 1960, le terme de neurosciences apparaît dans des publications en langue anglaise. Les neurosciences sont les études scientifiques du système nerveux, tant du point de vue de sa structure que de son fonctionnement, depuis l’échelle moléculaire jusqu’au niveau des organes, comme le cerveau, voire de l’organisme tout entier. Il s’agit d’un champ de recherche transdisciplinaire : la biologie, la chimie, les mathématiques, la bio-informatique ainsi que la neuropsychologie en font partie.

A partir de la fin du XX siècle on compte environ 35 000 nouvelles publications en neurosciences par année, ce qui ne permet plus à un chercheur isolé ou à une petite équipe de chercheurs de se tenir au courant des nouvelles découvertes et des nouvelles théories concernant le cerveau. Il faut disposer de modèles qui intègrent toutes les connaissances fragmentées, ce qui ne peut se faire que dans le cadre d’un large projet multidisciplinaire. [sta_anchor id=”brain-project” /]

Le premier projet de recherche sur le cerveau d’envergure est Blue Brain qui a pour objectif de créer un cerveau synthétique par processus de rétroingénierie. En 2005, Henry Markram, professeur de neurosciences à l’Ecole Polytechnique Fédérale de Lausanne (EPFL), convainc IBM de constituer une équipe internationale de 35 informaticiens, mathématiciens, biologistes et physiciens, pour développer une simulation informatique d’un cerveau. Henry Markham a été d’abord chercheur en Allemagne au Max Planck Institut für Medizinische Forschung à Heidelberg, ensuite chercheur sénior au Weizmann Institute of Science en Israel. A l’époque il était un des neuroscientifiques les plus estimés du monde.

En 2008, les chercheurs Blue Brain ont achevé une première étape : ils ont modélisé 10.000 neurones virtuels, connectés entre eux par 30.000.000 synapses, représentant la colonne corticale, c’est-à-dire l’unité de base du cortex, du cerveau d’un rat. Il faut toutefois se rappeler qu’un rat dispose de 18.000.000 neurones dans le cortex avec 448.000.000.000 synapses. Les résultats n’ont pas été publiés dans un journal scientifique examiné par des pairs. Henry Markram a promis de présenter un modèle virtuel complet d’un cerveau de mammifère en 2018 qui tournera sur le supercalculateur Blue Gene d’IBM, acquis par l’EPFL. Le projet Blue Brain reste toutefois très contesté et critiqué pour des raisons scientifiques et économiques.

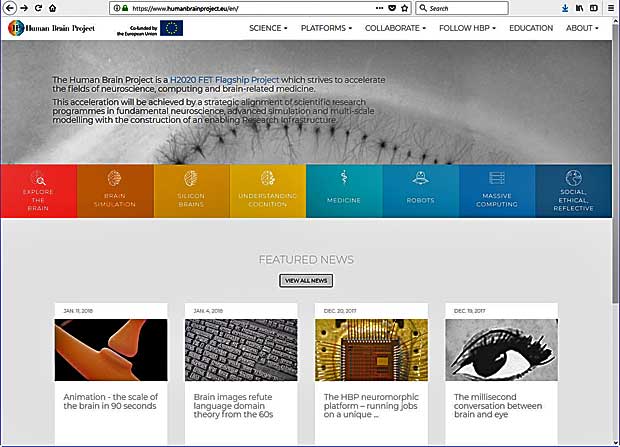

En 2012, Henry Markram a soumis le projet Humain Brain Project (HBP) comme extension de son projet Blue Brain à la Commission Européenne, en qualité de projet scientifique d’envergure qui vise à l’horizon 2024 de simuler le fonctionnement du cerveau humain grâce à un super-ordinateur. Le projet a été retenu en janvier 2013 comme une des Initiatives-Phare des Technologies Futures et Émergentes de l’Union Européenne (FET Flagship), soutenu financièrement à hauteur d’un milliard d’euros sur dix ans. Le projet devait se faire en collaboration avec plus de 90 instituts de recherche européens et internationaux, réparties dans 22 pays différents.

Le projet a démarré avec de grandes difficultés. En juillet 2014, une lettre ouverte a été adressée à la Commission Européenne dans laquelle 156 signataires exprimaient leurs doutes et craintes concernant l’organisation, la gestion et les ambitions du projet HBP. Dans la suite un total de 815 chercheurs ont signé cette lettre de protestation. Pour éviter un boycott par les partenaires, suivi d’un échec du projet, un comité de médiation a été mis en place et a élaboré un rapport de 53 pages pour réorienter la gestion et les objectifs du projet. Henry Markram est remplacé par le diplomate Christoph Ebell à la tête du projet sous la tutelle du vice-président de l’EPFL, Philippe Gillet, qui devient directeur général. La direction du projet est décentralisée, le rôle des partenaires est renforcé et des partenaires supplémentaires sont mis à bord, portant leur nombre total à 140. Certains observateurs sont d’avis que Henry Markram n’est pas le seul à l’origine des problèmes, mais que la Commission Européenne à Bruxelles n’a pas joué son rôle de supervision du projet.

A l’heure actuelle, le projet HBP est sur les bons rails et les premiers résultats sont publiés sur le site web www.humanbrainproject.eu. Les outils suivants sont à la disposition de l’ensemble des chercheurs : [sta_anchor id=”silicon-brains” /]

- Explore the brain : des atlas de référence avec des images de tranches histologiques de cerveaux humains (BigBrain, JuBrain), de rats (Waxholm) et de souris (Allen Mouse Brain) peuvent être explorés en ligne sur la plateforme neuroinformatique ou téléchargés

- Brain Simulation : une plateforme de simulation du cerveau (BSP) permet aux chercheurs du monde entier de tester leurs modèles et de comparer les résultats avec les prédictions

- Silicon Brains : une plateforme neuromorphique permet l’utilisation gratuite des ordinateurs sophistiqués SpiNNaker and BrainScaleS par des chercheurs pour des recherches spécifiques

- Understanding Cognition : les domaines de recherche sont la représentation des objets réels dans le cerveau, la conscience, le sommeil et la mémoire

- Médecine du cerveau : l’accès à des volumes importants de données médicales et d’images cérébrales sur la plateforme informatique médicale (MIP) offre aux chercheurs et ingénieurs la possibilité de développer des outils intelligents de diagnostic sur base de l’apprentissage profond

- Robots – Bodies for Brains : l’accès à la plateforme neurobotique permet de créer et de tester des applications robotiques dans un environnement réel (robots mécaniques) ou virtuel (simulations)

- Massive Computing : l’accès à la plateforme HPAC (High Performance Analytics & Computing) permet d’utiliser des super-calculateurs pour faire des simulations de cerveaux complets

- Ethics and Society : des questions légales, éthiques, culturelles et sociales, en relation avec le projet HBP, sont analysés dans ce sous-projet pour définir des bonnes pratiques dans l’intérêt de tous les acteurs

Le projet HBP fournit en outre des outils de collaboration entre chercheurs et maintient un site web dédié à l’éducation. Les progrès sont régulièrement annoncés sur les réseaux sociaux, les publications scientifiques relatives au projet sont listées sur le site web principal.

Quelques semaines après le lancement du projet HBP en Europe, le gouvernement américain a également lancé le 2 avril 2013 un projet de recherche d’envergure sur le cerveau, appelé Human Brain Activity Map. Le projet est maintenant plus connu sous le nom de BRAIN Initiative. Patronné par le National Institute of Health (NIH), le projet est réalisé par une alliance de partenaires fédéraux (NSF, DARPA, FDA, …). non-fédéraux (fondations, universités, instituts, industries, …) et de différents centres de recherche du NIH.

La mission de l’initiative BRAIN consiste à développer des nouvelles technologies pour explorer l’interaction entre les cellules et les circuits du cerveau et pour comprendre les liens entre le fonctionnement du cerveau et le comportement. Les principaux objectifs sont les suivants :

- Advance Neurotechnologies : stimuler le développement de nouvelles technologies de neurosciences

- Facilitate Dynamic Imaging : aider les chercheurs à créer des nouveaux outils d’imagerie cérébrale fonctionnant en temps réel

- Explore Brain Functionality : explorer comment le cerveau effectue l’acquisition, la sauvegarde, le traitement, l’utilisation et la récupération de vastes données d’information

- Link Function & Behavior : développer des théories et modèles pour mieux comprendre les liens entre le fonctionnenement du cerveau et le comportement

- Advance Consumer Applications : aider les ingénieurs à créer des nouveaux produits médicaux sans danger pour les patients et les consommateurs

Depuis le lancement en 2013, de nombreuses réussites sont relevées sur le site web du projet BRAIN Initiative :

Parmi les ressources organisées et conservées sur le site web BRAIN Initiative on trouve une liste impressionnante de documents, images, vidéos, données, publications, didactiels, programmes et autres outils.

Un des partenaires importants des projets HBP et BRAIN Initiative est le Allen Institute for Brain Science qui a déjà été présenté dans l’introduction. Les outils et produits proposés par cet Institut, la liste de ses publications et son atlas des cerveaux sont impressionants. La mission et l’impact de cet Institut permettent de le considérer comme un projet de recherche d’envergure distinct.

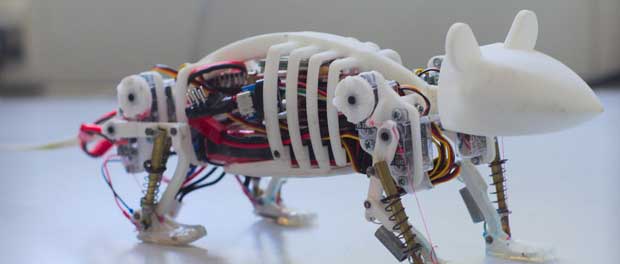

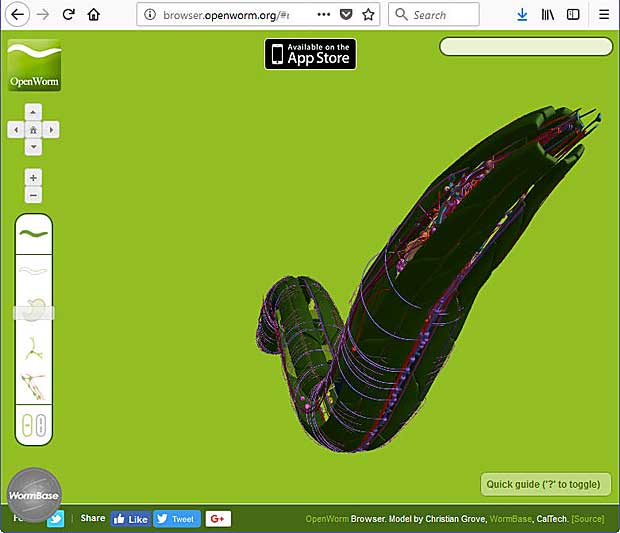

Un quatrième projet de recherche qu’il convient de relever est OpenWorm. Il n’est certes pas de la taille des autres, mais il est intéressant du fait de son financement participatif sur la plateforme Kickstarter. Je suis moi-même un des financiers de ce projet qui a recueilli 121.076 $US en 2014 de la part de 799 participants (backers). Le but du projet est de créer une simulation informatique complète d’un organisme vivant, le nématode (ver rond) C.elegans (Caenorhabditis elegans). Ce ver est un organisme modèle en biologie, car il permet l’étude de la mort programmée de certaines cellules, du développement embryonnaire et du vieillissement. L’adulte mâle est composé de 1031 cellules, dont 302 neurones, permettant également l’étude du système nerveux et du comportement. Les pères du modèle Caenorhabditis elegans, Sydney Brenner, John Sulston et Robert Horvitz, ont reçu le prix Nobel en 2002.

En 1998, ce ver fut le premier animal dont le génome a été totalement séquencé : 97 millions de paires de bases réparties en six chromosomes, codant 19.099 gènes. Quarante pour cent d’entre eux ont des équivalents dans le patrimoine génétique humain. Les ancêtres de ce ver ainsi que ceux des hommes ont divergé il y a 550 millions d’années. L’ensemble des informations génomiques concernant cet organisme sont compilées dans WormBase.

Une simulation du ver peut être effectuée dans un navigateur web. Une application pour iPAD, disponible dans le passé, a cessé de fonctionner suite à la mise à jour récente de iOS à la version 11. L’équipe OpenWorm est actuellement à la recherche d’un développeur bénévole pour adapter le logiciel afférent, disponible en libre source.

Le modèle 3D de l’OpenWorm est basé sur le projet VirtualWorm réalisé au CalTech. Toutes les sources du projet OpenWorm sont disponibles sur GitHub.

Les outils utilisés pour explorer OpenWorm sont :

- Sibernetic : moteur physique de simulation

- Gepetto : plateforme de simulation biologique

- Connectome : modèle NeuroML et Open Source Brain

- NeuroConstruct : logiciel pour développer des modèles biologiqes en 3D

- CyberElegans : modéle neuromécanique

- WormBrowser : visualisation du modèle dans un navigateur web

- OpenWorm Database : base de données sur GoogleDrive

- Documentation : site web docs.openworm.org

- Publications : liste de publications liées au projet OpenWorm

6. Les philosophies de la conscience

Après avoir fait le tour de certains acteurs et environnements du domaine des neurosciences, il est temps de s’intéresser aux approches philosophiques classiques de la conscience, pour se focaliser ensuite sur les théories modernes.

Les philosophies classiques de la conscience se résument comme suit :

- l’idéalisme : le monde matériel est considéré comme une simple illusion de notre conscience -> Berkeley, Hegel, Schopenhauer, …

- le dualisme : il existe deux mondes, celui de la matière et de l’esprit -> Descartes, …

- le matérialisme : il n’y a rien d’autre dans le monde que de la matière -> Démocrite, Epicure, …

- le mystérianisme : la conscience restera pour toujours un mystère -> Colin McGinn

Les critiques formulées à l’encontre de chacune de ces options ont amené leurs défenseurs à raffiner chacune d’elles, ce qui a donné lieu à de nombreuses variantes, par exemple le physicalisme, le naturalisme, …

Une variante, le panpsychisme, selon laquelle il y a une conscience en toute chose, vient de gagner d’actualité avec les théories modernes sur la conscience. Dans un article d’un Hors série de la revue La Recherche daté d’octobre 2015 consacré à la conscience, David Chalmers actualise une hypothèse qui a toujours été la sienne, selon laquelle la conscience serait un phénomène universel comme le temps et l’espace.

7. Les théories modernes sur la conscience

Les différentes théories récentes sur la conscience sont résumées ci-après, par ordre chronologique :

La conscience quantique (> 1960)

La conscience quantique est une hypothèse qui suggère que des phénomènes quantiques, tels l’intrication et la superposition d’états, sont impliqués dans le fonctionnement du cerveau, et en particulier dans l’émergence de la conscience. Cette hypothèse part du principe, controversé, que la physique classique et son déterminisme ne peuvent totalement expliquer la conscience.

La physique quantique, née au XXe siècle, marque une rupture avec ce que l’on appelle maintenant la physique classique. Depuis les années 1990, les ingénieurs cherchent à construire des ordinateurs quantiques qui ne travaillent plus sur des données binaires, mais sur des qubits dont l’état quantique peut posséder plusieurs valeurs.

La théorie de la conscience quantique est promue par le physicien et mathématicien britannique Roger Penrose (collaborateur de Stephen Hawking), par Stuart Hameroff et par Gustav Bernroider. Les deux premiers s’intéressent à la délocalisation des électrons dans les poches hydrophobes des microtubules, qui forment l’ossature des cellules, tandis que Gustav Bernroider se focalise sur l’étude des poches semblables, mais au centre de canaux ioniques, qui sont localisés sur la surface de la cellule.

Le célèbre philosophe David Chalmers, qui est particulièrement connu pour sa formulation du problème difficile de la conscience (The Hard Problem), plaisante que la théorie de l’esprit quantique est une “Loi de Réduction du Mystère” : la conscience est mystérieuse et la mécanique quantique l’est aussi, peut-être alors ces deux mystères ont-ils une source commune.

Le mécanisme de convergence – divergence (1989)

La théorie des zones de convergence-divergence a été proposée en 1989 par António Damásio, médecin, professeur de neurologie, neurosciences et psychologie à l’université de Californie du Sud, pour expliquer les mécanismes neuronaux de la mémorisation et de la remémorisation. Elle est basée sur les idées de Bernard Baars et permet également d’expliquer d’autres formes de la conscience dont l’imagination créatrice, la pensée, ou encore la formation des croyances et des motivations. Elle repose sur deux hypothèses principales : l’imagination est une simulation de la perception, les inscriptions cérébrales des souvenirs sont des réseaux neuronaux autoexcitateurs.

Le modèle des versions multiples (1991)

Le modèle des versions multiples de la conscience a été présenté en 1991 par le philosophe américain Daniel Dennett dans son livre Consciousness Explained. Il explique les mécanismes de la conscience en faisant largement appel aux sciences cognitives. Selon sa théorie, les réponses comportementales du cerveau sont les résultats obtenus au terme d’une compétition darwinienne. Il a introduit le concept de la célébrité cérébrale selon lequel la conscience propagage dans tout le cerveau les idées jugées dignes d’être célèbre.

L’espace de travail neuronal global (2001)

L’espace de travail neuronal global, ou espace de travail global conscient, est une théorie publiée en 2001 par Stanislas Dehaene et Lionnel Naccache dans le journal Cognition 79. La publication porte le titre “Towards a cognitive neuroscience of consciousness: basic evidence and a workspace framework“.

Cette théorie formalise l’espace cérébral conscient comme un réseau central permanent à partir duquel le contenu de notre conscience est à chaque instant identifiable à l’activité neuronale cohérente et temporellement stabilisée au cœur de cet espace de travail global. L’idée centrale de ce modèle biologique de la conscience consiste à postuler une double architecture anatomique et fonctionnelle du cerveau distinguant les phénomènes conscients et inconscients. La théorie est supportée par le biologiste français renommée Jean-Pierre Changeux.

L’information intégrée (2004)

En 2004, Giulio Tononi présentait dans BMC Neuroscience sa théorie de l’information intégrée de la conscience (IIT). En 2008, il publiait un manifeste au sujet de l’IIT dans le volume 215 du Biological Bulletin. Cette théorie est partagée par Christof Koch.

Un quatrième état de la matière : perceptronium (2014), sentronium (2017)

Un des supporteurs enthousiastes de l’IT est Max Tegmark, physicien et cosmologiste renommé au MIT, qui a généralisé la théorie de la conscience de Guilio Tononi en 2014 en introduisant le perceptronium. Sa contribution afférente Consciousness as a State of Matter a été publiée en mars 2015 dans le journal Chaos, Solitons & Fractals. En se référant aux trois états de la matière, solide, liquide, gazeux, il définit la conscience comme un quatrième état, appelé perceptronium, une extension du computronium. En 2017, Max Tegmark a remplacé le terme perceptrorium par le terme plus général sentronium.

Max Tegmark est un fervent adversaire de la théorie de la conscience quantique. Sur la base de ses calculs, il a conclu que les systèmes quantiques dans le cerveau décohèrent rapidement et ne peuvent pas contrôler le fonctionnement du cerveau

8. Evaluation des théories récentes de la conscience

J’ai suivi les progrès réalisés dans les domaines de l’intelligence artificielle et de la conscience synthétique depuis des dizaines d’années, d’abord sur base de livres, ensuite grâce à Internet qui est un outil formidable pour s’informer sur l’évolution de projets de recherche. Les dernières années j’étais en mesure d’effectuer moi-même des tests et de réaliser des expériences dans ces domaines, grâce aux outils et ressources en ligne mis à disposition par la communauté scientifique.

Je considère que la théorie de l’information intégrée est la plus plausible pour expliquer le fonctionnement de la conscience, pour les raisons suivantes :

- c’est une vraie théorie scientifique, basée sur les mathématiques et la physique classique

- la théorie définit une valeur de mesure du degré de conscience appelée phi

- des outils et modèles pour explorer la théorie sont mis à disposition des intéressés sur un site web dédié

- la théorie n’est pas incompatible avec les autres théories modernes présentées ci-avant, excepté la théorie de la conscience quantique

- les partisans de cette théorie, Christof Koch et Max Tedmark, font partie des chercheurs les plus estimés du monde

- une communauté croissante de checheurs du domaine de la conscience adhèrent progressivement à cette théorie

Il convient donc de s’intéresser plus en détail pour la théorie de l’information intégrée, ce qu’on va faire dans la suite. Mais avant de parler d’information intégrée, il faut comprendre ce qu’on entend par l’information toute simple et comment l’information est transmise au cerveau.

9. La théorie de l’information

La théorie de l’information trouve son origine scientifique avec Claude Shannon, ingénieur en télécommunications à la Compagnie des Téléphones Bell, qui en est le père avec son article A Mathematical Theory of Communication, publié en 1948. Il s’agit d’une théorie probabiliste permettant de quantifier le contenu moyen en information d’un ensemble de messages, dont le codage informatique satisfait une distribution statistique précise.

La théorie mathématique de l’information résulte initialement des travaux de Ronald Aylmer Fisher. Celui-ci, biologiste et statisticien britannique, définit formellement l’information comme égale à la valeur moyenne du carré de la dérivée partielle (δ) du logarithme naturel de la loi de probabilité étudiée.

En termes simples, moins une observation est probable, plus elle est porteuse d’information. Lorsque le journaliste commence le journal télévisé par la phrase “Bonsoir”, ce qui est probable, ce mot n’apporte que peu d’information. En revanche, si la première phrase commence par “Il y a 312 morts …“, sa faible probabilité fera que l’auditeur apprends qu’il s’est passé quelque chose et sera plus à l’écoute.

Claude Shannon et Warren Weaver se préoccupaient de mesurer l’information pour en déduire les fondamentaux de la communication et modélisaient l’information pour étudier les lois correspondantes : bruit, entropie et chaos.

Cette théorie a été développée dans les laboratoires Bell pour des raisons pratiques. Dans un système de communication on cherchait à transmettre des messages de la façon la plus fiable et la plus économique à travers un canal matériel – énergétique donné (fil téléphonique, onde radio, fibre optique, …). Emetteur et récepteur utilisent un répertoire commun (code) qui contient les signaux utilisables. Le message codé est transmis de l’émetteur au récepteur à travers le canal sous forme de signaux adaptés au matériel – énergie utilisé.

L’information de Shannon se mesure en unités binaires dites bits, la quantité d’information effectivement transmise s’exprime en shannons.

L’entropie mathématique de Shannon, pour une source de données, donne une mesure de l’information minimale que l’on doit conserver afin de représenter ces données sans perte. La formule de l’entropie, sans entrer dans les détails, est indiquée ci-après, simplement pour en montrer la complexité.

La théorie de communication de Shannon est souvent appelée théorie de l’information, bien qu’elle ne couvre ni la physique, ni la sémantique. Après sa publication, elle a été rapidement appliquée dans le domaine des sciences humaines, notamment dans les domaines de psycholinguistique et de cybernétique.

A côté de la théorie (mathématique) de l’information de Shannon utilisée en informatique, en télécommunications et en neurosciences computationnelles, on distingue encore la théorie algorithmique de l’information qui se réfère à la notion de complexité et la théorie sémantique de l’information qui se réfère à la linguistique.

La coïncidence étonnante entre l’équation de Shannon pour l’entropie de l’information et l’équation de Boltzmann – Gibbs pour l’entropie en themodynamique, mais de signe inverse, ont fait dire à Norber Wiener, le père fondateur de la cybernétique, que “L’information n’est ni la masse, ni l’énergie, l’information est l’information.“, ce qui a laissé la porte ouverte à la conception qu’il y a un troisième constituant de l’univers, à côté de la masse et de l’énergie.

Guilio Tononi applique la théorie et les lois de Shannon sur son modèle de la conscience. Nous allons explorer d’abord comment l’information est perçue par le cerveau.

10. Les cinq sens du corps humain

Un individu reçoit une multitude d’informations par l’intermédiaire de ses organes sensoriels (yeux, peau, oreilles, nez, langue), constituant un premier contact avec le monde extérieur. Ce phénomène de stimulation des sens est appelé sensation. La cause physique externe de la sensation est appelé stimulus.

a) La sensation est universelle : tout être humain perçoit l’environnement avec un ou plusieurs de ses sens.

b) La sensation est relative : les stimuli ne sont pas ressentis par tous de la même manière. Certaines personnes ont chaud quand le thermomètre affiche 19°, alors que d’autres ont l’impression qu’il fait frais. Certains stimuli, par leur permanence, finissent par être oubliés, comme le bruit de la rue.

A la réception d’un stimulus, l’individu va organiser et interpréter ses différentes sensations en fonction de l’environnement dans lequel il se trouve. Ce processus s’appelle la perception.

Le processus de perception comprend plusieurs étapes au sein du cerveau :

- l’attention : les informations sensorielles sont sélectionnées et retenues

- l’interprétation : les informations sensorielles retenues sont transformées en impressions

- la compréhension : une signification est donnée aux informations sensorielles retenues

- la mémorisation : les informations sensorielles retenues, interprétées et comprises sont archivées

c) La perception est globale : si on se trouve sur une plage, on voit le sable, la mer, l’horizon et le ciel avec des nuages. Le soleil pique sur la peau, on entend le bruit des vagues et les cris des mouettes. En respirant on sent l’odeur des algues, en léchant ses lèvres on découvre le goût du sel. Bien que toutes ces différentes informations qui passent par les cinq sens du corps humain (vue, toucher, ouïe, odorat et goût), activent différentes zones espacées dans le cerveau, cette expérience est sentie comme une perception globale.

d) La perception est sélective : on ne voit, ne sent et n’entend pas tout en même temps en fonction de différents facteurs. Un stimulus peut être tellement fort quand ne percoit pas les autres. Certains phénomèmes peuvent perturber la perception. Les biais perceptuels sont de trois natures:

- situationnelle : la perception est influencée par le contexte

- Individuelle : la perception est sélective en fonction de l’état personnel d’un individu (avoir faim ou soif, être fatigué, souffrir des douleurs, …)

- sociale : la perception dépend des représentations sociales (opinions, préjugés, stéréotypes, fausses idées, …)

e) La perception est limitée : l’information qui peut être traitée par un individu est limitée. Le principe de Russel Ackoff postule qu’au delà d’une certaine masse de données la quantité d’information baisse et devient même nulle. “Trop d’infomation tue l’information“.

La perception globale donne naissance à la conscience, ce que la théorie de l’information intégrée tente de quantifier avec une formule mathématique.

11. La théorie de l’information intégrée (ITT)

Guilio Tononi et ses collaborateurs Masafumi Oizumi et Larissa Albantakis ont publié en mai 2014 la troisième version de la théorie de l’information intégrée de la conscience dans le journal Computational Biology.

Consciousness: here, there and everywhere? est le titre d’une contribution publiée en 2015 par Giulio Tononi et Christof Koch dans les Transactions Philosophiques de la Société Royale B.

La publication la plus récente porte le titre Integrated information theory: from consciousness to its physical substrate. Parue en mai 2016 dans le journal Nature Reviews Neuroscience 17, elle est signée Guilio Tononi, Melanie Boly, Marcello Massimini et Christof Koch.

Un des adversaires acharnés de l’IIT et du perceptronium de Max Tedmark est Scott Aaronson, professeur en informatique quantique au MIT, qui exprimait ses opinions sur cette théorie sur son blog en mai 2014 : Why I Am Not An Integrated Information Theorist. Les liens suivants pointent vers la prise de position afférente de Guilio Tononi et la réponse de Scott Aaronson.

La théorie de l’information intégrée de Guilio Tononi est fondée sur cinq axiomes :

- existence intrinsèque : ma conscience est réelle et elle existe

- composition : ma conscience est structurée; mon expérience est composée de différents éléments phénoménologiques (différentes couleurs, différents objets, différents emplacements dans l’espace, …)

- information : ma conscience est spécifique; mon expérience présente est différente de mes autres expériences futures ou anciennes (autres couleurs, autres objets, autres odeurs, …)

- intégration : ma conscience est unitaire; mon expérience ne peut pas être réduite à un sous-ensemble phénoménologique (noir-blanc au lieu d’une couleur, vue du sable et du ciel sur la plage sans voir la mer, …)

- exclusion : ma conscience est déterminée dans le contenu, l’espace et le temps. Mon expérience n’a ni moins, ni plus de distinctions phénoménologiques que celles que je perçois et elle ne dure ni moins, ni plus longtemps que quelques fractions de secondes.

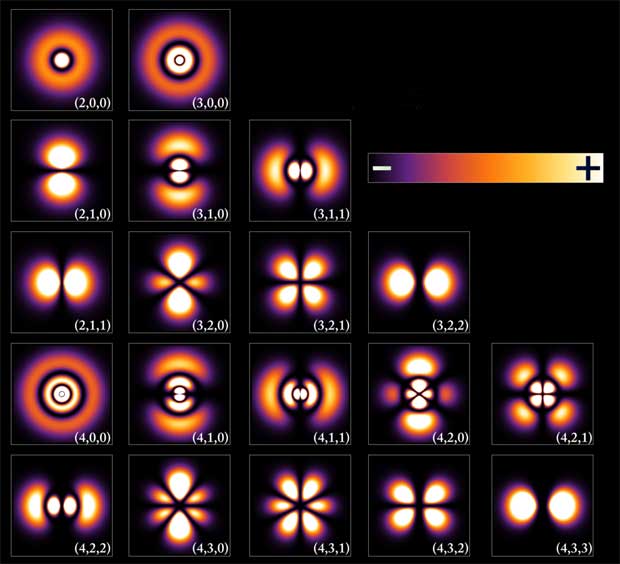

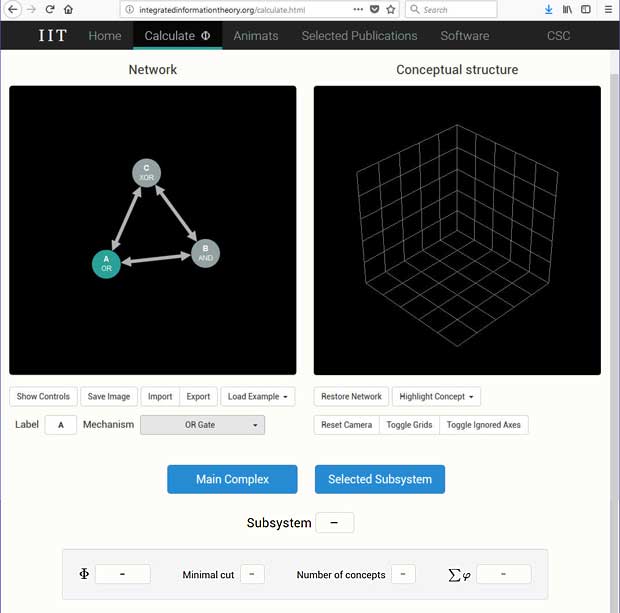

A partir des cinq axiomes, Guilio Tononi a défini cinq postulats pour expliquer le mécanisme de la conscience et pour calculer la quantité de conscience Φ (phi), moyennant des portes logiques AND, OR et XOR.

Une librairie Python pour calculer est disponible dans le répertoire pyphi sur GiHub. Ce logiciel est présenté dans la contribution PyPhi: A toolbox for integrated information theory publiée fin décembre 2017 par William G. P. Mayner, William Marshall, Larissa Albantakis, Graham Findlay, Robert Marchman et Giulio Tononi. Un didactiel Calculating Φ de 237 pages accompagne cette publication.

La démarche scientifique classique pour expliquer le phénomène de la conscience était basée sur l’analyse des propriétés du cerveau. Guilio Tononi a pris la démarche inverse en se basant sur les propriétés de la conscience pour dégager les fonctionnalités requises par un système pour supporter la conscience.

12. Evénements AI et IIT

Les dernières années ont été marquées par de nombreux colloques, forums, conférences, ateliers et séminaires au sujet de l’intelligence artificielle (AI) et des théories de la conscience et de l’ITT.

Max Tedmark était à l’initiative de la première conférence mondiale concernant la sécurité de l’AI qui a réuni les chercheurs les plus brillants de ce domaine, parmi eux Joscha Bach, Nick Bostrom, Erik Brynjolfsson, Christof Koch, Elon Musk, Stuart Russel et Vernor Vinge. Cette conférence a eu lieu à Porto Rico en janvier 2015. Suite à cette conférence, une lettre ouverte au sujet des recherches prioritaires pour garantir une AI bénéfique pour l’humanité a été signée par plus de 8.000 chercheurs.

Une deuxième conférence appelée AI bénéfique 2017 a eu lieu en janvier 2017 à Asilomar en Californie. 23 principes pour favoriser une AI bénéfique ont été retenus lors de cette conférence et signés par 1.273 chercheurs du domaines AI / Robotique et par 2.541 chercheurs d’autres domaines.

John Horgan, un journaliste scientifique américan renommé, a décrit en décembre 2015 dans le blog du Scientific American ses expériences lors de sa participation à un atelier (workshop) de deux jours au sujet de l’IIT à l’université de New York en novembre de la même année. Guilio Tononi, Christof Koch, David Chalmers et dix autres orateurs ont présenté pendant des heures des concepts complexes, de façon abstraite et mathématique. John Morgan avouait qu’il avait des difficultés à suivre la théorie exposée, tout comme une partie des autres auditeurs. C’était lors de cet atelier que l’informaticien Scott Aaronson formulait publiquement son scepticisme vis-à-vis de l’IIT.

A la fin de son article, John Horgan proclamait qu’il n’avait pas appris grand-chose au sujet de la conscience, mais que cet atelier était l’expérience scientifique la plus exaltante qu’il a connu depuis longtemps. Voyant toutes ces grosses têtes se battre verbalement concernant la validité de phi était un spectacle hilarant.

13. Conclusions

Bien que j’estime déjà que Furby soit conscient, même si ce n’est qu’à un degré minimal, je vais essayer de mieux comprendre l’utilisation du logiciel pyphi et de calculer Φ pour différents systèmes. Je suis convaincu que la conscience est effectivement un troisième constituant de la matière, à côté de la masse et de l’énergie, et qu’elle n’est pas seulement limitée aux organismes vivants. Je partage la théorie de Max Tedmark qui définit la conscience comme un quatrième état de la matière, à coté des états solides, liquides et gazeux.

Une conséquence des nouvelles théories est qu’on ne peut pas parler de conscience scientifique; il n’y a qu’une seule conscience. Le slogan de mon site web “… and Internet gets a synthetic consciousness” introduit il y a une dizaine d’années, est donc mal choisi. Toutefois je ne vais pas le changer pour des raisons historiques.

Il va de soi que la théorie de l’information intégrée n’est qu’à ses débuts et qu’il reste beaucoup de mystères à résoudre, par exemple la notion de libre arbitre, l’état d’hypnose, l’émergence des rêves, les expériences hors-corps, … L’IIT a toutefois le mérite d’être la première théorie scientifique quantifiable qui est explorée et partagée par une communauté croissante de neuroscientifiques.

Le lecteur intéressé trouve ci-après une liste bibliographique de livres, sites web et vidéos que je recommande pour approfondir les sujets en relation avec la conscience. Elle est complémentaire aux liens indiqués dans le texte.

14. Bibliographie

Livres :

- Life 3.0 : Being human in the age of Artificial Intelligence, 2017; Max Tegmark ; ISBN 978-0-241-32719-9

- Le mythe de la singularité : faut-il craindre l’intelligence artificielle ?, 2017; Jean-Gabriel Ganascia; ISBN 978-2-02-130999-7

- Creation of a conscious robot : mirror image recognition and self-awareness, 2013; Junichi Takeno; ISBN 978-981-4364-49-2

- How to build a brain : a neural architecture for biological cognition, 2013; Chris Eliasmith; ISBN 978-0-19-979454-6

- How to create a mind: the secret of human thought revealed, 2012: Ray Kurzweil; ISBN 978-0-670-02529-9

- Consciousness and robot sentience, 2012; Pentti O Haikonen; ISBN 978-981-4407-15-1

- Consciousness : Confessions of a romantic reductioniste, 2011; Christof Koch; ISBN 978-0-262-01749-7

- The creation of a conscious machine, 2011; Jean Tardy; ISBN 978-1-1484823316

- Principles of synthetic intelligence : Psi – an architecture of motivated cognition, 2009; Joscha Bach; ISBN 978-0-19-537-067-6

- Galilée et la photodiode : Cerveau, complexité et conscience, 2006 ; Giulio Tononi ; ISBN

Sites web :

- Future of Life Institute : Technology is giving life the potential to flourish like never before … or to self-destruct. Let’s make a difference ! Institute co-founded by Max Tedmark.

- Singularity University : Be Exponential. We empower a global community with the mindset, skillset, and network to create an abundant future. University co-founded by Ray Kurzweil

- 2045 Initiative : founded by Dmitry Itskov

- Cosmic Evolution : From Big Bang to Humankind, by Eric J. Chaisson

- The Information Philosopher : solving philosophical problems with the new information philosophy (i-Phy), by Robert Doyle

- The Metaphysicist : solving metaphysical problems with information philosophy, by Robert Doyle

- Knowing Neurons : A creative neuroscience education website by young neuroscientists

- Qualia Research Institute : QRI at The Science of Consciousness 2018

- Big Think : Why a “genius” scientist thinks our consciousness originates at the quantum level

- Rock Consciousness : The idea that everything from spoons to stones is conscious is gaining academic credibility/

- Two rival theories of consciousness are put to the test, The Economist

Videos :

- Your brain hallucinates your conscious reality : Anil Seth 2017

- On Consciousness with Giulio Tononi, Max Tegmark and David Chalmers : 2017

- Giulio Tononi on Consciousness : 2017

- How Human Consciousness Evolved : Daniel Dennett 2017

- The quantum nature of consciousness : Sir Roger Penrose 2017

- Researchers say there’s evidence that consciousness continues after clinical death : 2017

- From Artificial Intelligence to Artificial Consciousness : Joscha Bach at TEDxBeaconStreet 2016

- After watching this, your brain will not be the same : Lara Boyd at TEDxVancouver 2015

- What is consciousness? : The Economist 2015

- Consciousness is a mathematical pattern : Max Tegmark at TEDxCambridge 2014

- The scientific pursuit of consiousness : Christof Koch at TEDxRainier 2014

- Consciousness — the final frontier :Dada Gunamuktananda at TEDxNoosa 2014

- Consciousness Can be Quantified : Michio Kaku 2014

- Comment expliquer la conscience ? : David Chalmers 2014

- The Reality of Consciousness : Peter Russell 2014

- Consciousness & the Brain : John Searle at TEDxCERN 2013

- The Future of Consciousness : Stuart Hameroff at TEDxTucson 2013

- Consciousness Drives The Universe : 2008